Bu belgede, cihaz üzerinde kişiselleştirme (ODP) ile ilgili gizlilik yaklaşımı, özellikle diferansiyel gizlilik bağlamında özetlenmektedir. Bu belgenin odak noktasını korumak için veri minimizasyonu gibi diğer gizlilik etkileri ve tasarım kararları kasıtlı olarak dışarıda bırakılmıştır.

Diferansiyel gizlilik

Diferansiyel gizlilik 1, istatistiksel veri analizinde ve makine öğreniminde 2 yaygın olarak kullanılan bir gizlilik koruma standardıdır 3. Gayri resmi olarak, bir saldırganın, kayıtları temel veri kümesinde görünse de görünmese de diferansiyel gizlilik algoritmasının çıkışından bir kullanıcı hakkında neredeyse aynı şeyi öğrendiği söylenir. Bu, bireyler için güçlü korumalar anlamına gelir: Bir kişi hakkında yapılan tüm çıkarımlar, yalnızca veri kümesinin toplu özelliklerinden kaynaklanabilir. Bu özellikler, söz konusu kişinin kaydı olsa da olmasa da geçerli olur.

Makine öğrenimi bağlamında, algoritmanın çıkışı eğitilmiş model parametreleri olarak düşünülmelidir. Neredeyse aynı şey ifadesi, matematiksel olarak iki parametreyle (ε, δ) ölçülür. Burada ε genellikle küçük bir sabit olarak seçilir ve δ≪1/(kullanıcı sayısı) olur.

Gizlilik anlamları

ODP tasarımı, her eğitim çalıştırmasının (ε,δ) kullanıcı düzeyinde farklı gizlilik sağladığından emin olmayı amaçlar. Aşağıda, bu anlamsal öğeye ulaşma yaklaşımımız özetlenmektedir.

Tehdit modeli

Farklı tarafları tanımlar ve her biriyle ilgili varsayımları belirtiriz:

- Kullanıcı: Cihazın sahibi olan ve geliştiricinin sağladığı ürün veya hizmetleri kullanan kişiler. Kullanıcılar, kendi özel bilgilerine tam olarak erişebilir.

- Güvenilir yürütme ortamı (TEE): TEE'lerde gerçekleşen veriler ve güvenilir hesaplamalar, çeşitli teknolojiler kullanılarak saldırganlara karşı korunur. Bu nedenle, hesaplama ve veriler ek koruma gerektirmez. Mevcut TEE'ler, proje yöneticilerinin içindeki bilgilere erişmesine izin verebilir. Erişimin bir yönetici tarafından kullanılamadığını doğrulamak ve buna izin vermemek için özel özellikler öneriyoruz.

- Saldırgan: Kullanıcı hakkında ek bilgilere sahip olabilir ve TEE'den çıkan tüm bilgilere (ör. yayınlanan model parametreleri) tam erişimi vardır.

- Geliştirici: Modeli tanımlayan ve eğiten kişi. Güvenilmeyen olarak kabul edilir (ve saldırganın tüm yeteneklerine sahiptir).

ODP'yi aşağıdaki diferansiyel gizlilik semantiğiyle tasarlamayı amaçlıyoruz:

- Güven sınırı: Bir kullanıcının bakış açısından güven sınırı, kullanıcının kendi cihazı ve TEE'den oluşur. Bu güven sınırının dışına çıkan tüm bilgiler, diferansiyel gizlilik ile korunmalıdır.

- Saldırgan: Saldırganla ilgili olarak tam diferansiyel gizlilik koruması. Güven sınırının dışındaki herhangi bir öğe saldırgan olabilir (geliştirici ve diğer kullanıcılar da buna dahildir ve hepsi potansiyel olarak gizli anlaşma yapabilir). Saldırgan, güven sınırının dışındaki tüm bilgiler (ör. yayınlanan model), kullanıcıyla ilgili tüm yan bilgiler ve sınırsız kaynaklar verildiğinde, gizlilik bütçesinin verdiği olasılıklara kadar kullanıcı hakkında yan bilgilerde zaten bulunanların ötesinde ek özel veriler çıkaramaz. Bu durum, özellikle geliştiriciye karşı tam diferansiyel gizlilik koruması anlamına gelir. Geliştiriciye verilen tüm bilgiler (ör. eğitilmiş model parametreleri veya toplu çıkarımlar) farklı gizlilik ile korunur.

Yerel model parametreleri

Önceki gizlilik semantiği, model parametrelerinin bir kısmının cihaza özgü olduğu durumu (ör. her kullanıcıya özgü kullanıcı yerleştirme içeren ve kullanıcılar arasında paylaşılmayan bir model) destekler. Bu tür modellerde, yerel parametreler güven sınırları içinde kalır (yayınlanmaz) ve korunması gerekmez. Paylaşılan model parametreleri ise yayınlanır (ve farklı gizlilik ile korunur). Bu bazen billboard gizlilik modeli 4 olarak da adlandırılır.

Herkese açık özellikler

Bazı uygulamalarda özelliklerin bir kısmı herkese açıktır. Örneğin, film önerisi sorununda bir filmin özellikleri (yönetmeni, türü veya yayınlanma yılı) herkese açık bilgilerdir ve korunması gerekmez. Kullanıcıyla ilgili özellikler (ör. demografik bilgiler veya kullanıcının izlediği filmler) ise özel verilerdir ve korunması gerekir.

Herkese açık bilgiler, tüm tarafların erişebileceği herkese açık bir özellik matrisi olarak resmileştirilir (önceki örnekte bu matris, film başına bir satır ve film özelliği başına bir sütun içerir). Diferansiyel gizlilik sağlayan eğitim algoritması, bu matrisi korumaya gerek kalmadan kullanabilir. Örneğin, 5'e bakın. ODP platformu bu tür algoritmaları uygulamayı planlamaktadır.

Tahmin veya çıkarım sırasında gizliliğe yönelik bir yaklaşım

Çıkarımlar, model parametrelerine ve giriş özelliklerine dayanır. Model parametreleri, diferansiyel gizlilik semantiğiyle eğitilir. Burada, giriş özelliklerinin rolü ele alınmaktadır.

Bazı kullanım alanlarında, geliştirici çıkarımda kullanılan özelliklere zaten tam erişime sahip olduğunda çıkarımla ilgili gizlilik endişesi yoktur ve çıkarım sonucu geliştirici tarafından görülebilir.

Diğer durumlarda (çıkarımda kullanılan özellikler özel olduğunda ve geliştirici tarafından erişilemediğinde) çıkarım sonucu geliştiriciden gizlenebilir. Örneğin, çıkarımın (ve çıkarım sonucunu kullanan tüm sonraki işlemlerin) cihaz üzerinde, işletim sistemine ait bir süreçte ve görüntüleme alanında çalıştırılması ve bu sürecin dışında iletişimin kısıtlanması gibi.

Eğitim prosedürü

Genel Bakış

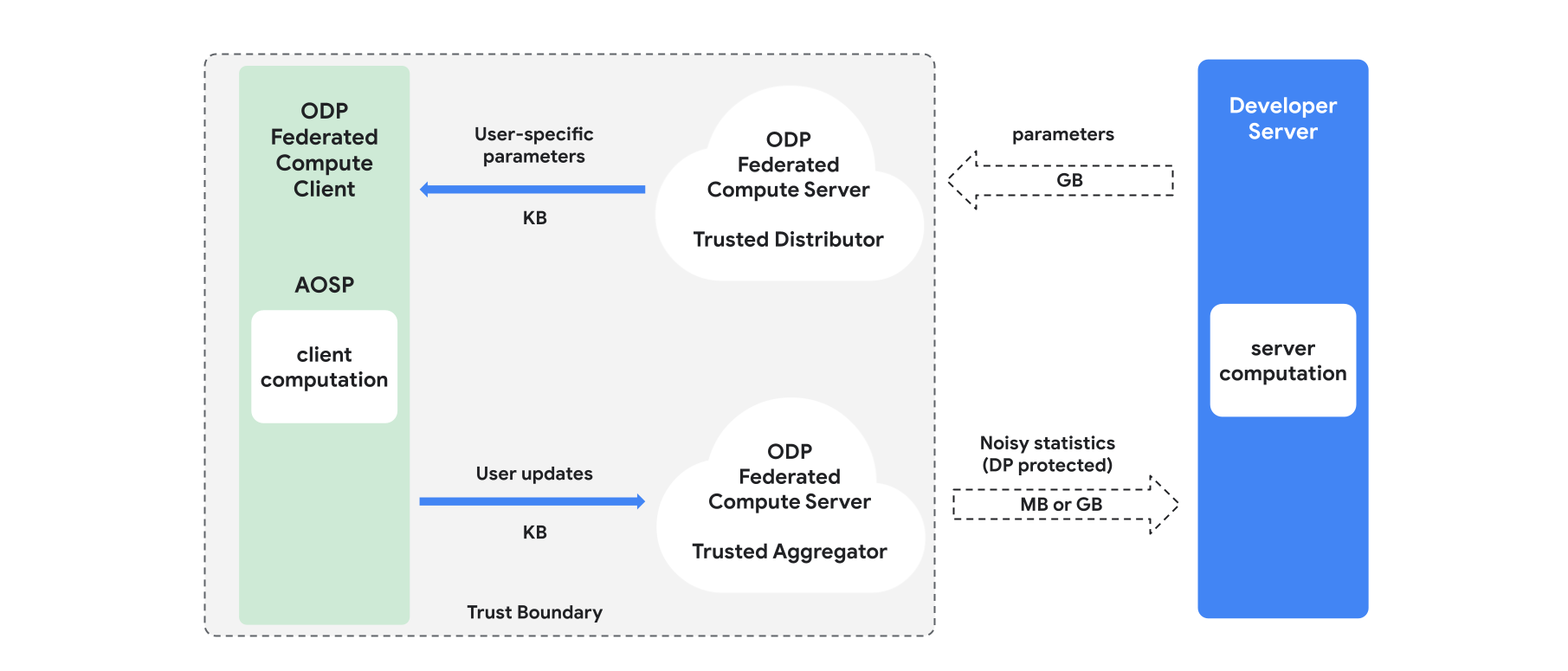

Bu bölümde, mimariye ve eğitimin nasıl ilerlediğine dair genel bir bakış sunulmaktadır (Şekil 1). ODP aşağıdaki bileşenleri uygular:

Model parametrelerini yayınlama rolünü üstlenen, güvenilir bir dağıtıcı (ör. federated select, trusted download veya private information retrieval). Güvenilir distribütörün, hangi istemcinin hangi parametreleri indirdiğini açıklamadan her istemciye bir parametre alt kümesi gönderebileceği varsayılır. Bu "kısmi yayın", sistemin son kullanıcı cihazındaki yer kaplama alanını en aza indirmesine olanak tanır. Modelin tam bir kopyasını göndermek yerine, model parametrelerinin yalnızca bir kısmı belirli bir kullanıcıya gönderilir.

Birden fazla istemciden bilgi (ör. gradyanlar veya diğer istatistikler) toplayan, gürültü ekleyen ve sonucu sunucuya gönderen güvenilir bir toplayıcı. İstemci ile toplayıcı ve istemci ile dağıtıcı arasında güvenilir kanallar olduğu varsayılır.

Bu altyapıda çalışan DP eğitim algoritmaları. Her eğitim algoritması, farklı bileşenlerde (sunucu, istemci, toplayıcı, dağıtıcı) çalışan farklı hesaplamalardan oluşur.

Tipik bir eğitim turu aşağıdaki adımlardan oluşur:

- Sunucu, model parametrelerini güvenilir distribütöre yayınlar.

- İstemci tarafında hesaplama

- Her istemci cihaz, yayın modelini (veya kullanıcıyla alakalı parametrelerin alt kümesini) alır.

- Her istemci, bazı hesaplamalar (ör. gradyanları veya diğer yeterli istatistikleri hesaplama) yapar.

- Her istemci, hesaplamanın sonucunu güvenilir toplayıcıya gönderir.

- Güvenilir toplayıcı, istemcilerden gelen istatistikleri uygun diferansiyel gizlilik mekanizmalarını kullanarak toplar, toplar ve korur, ardından sonucu sunucuya gönderir.

- Sunucu hesaplaması

- (Güvenilmeyen) sunucu, farklı gizlilikle korunan istatistikler üzerinde hesaplamalar yapar (ör. model parametrelerini güncellemek için farklı gizlilikle korunan toplu gradyanları kullanır).

Çarpanlara ayrılmış modeller ve farklı gizlilikle alternatif minimizasyon

ODP platformu, herhangi bir model mimarisine (ör. DP-SGD 6 7 8 veya DP-FTRL 9 10) uygulanabilen genel amaçlı diferansiyel gizlilikli eğitim algoritmalarının yanı sıra faktörize edilmiş modellere özel algoritmalar sağlamayı planlamaktadır.

Çarpanlara ayrılmış modeller, alt modellere (kodlayıcılar veya kuleler olarak adlandırılır) ayrıştırılabilen modellerdir. Örneğin, f(u(θu, xu), v(θv, xv)) biçimindeki bir modeli ele alalım. Burada u(), kullanıcı özelliklerini xu kodlar (ve θu parametrelerine sahiptir) ve v(), kullanıcı dışı özellikleri xv kodlar (ve θv parametrelerine sahiptir). İki kodlama, nihai model tahminini oluşturmak için f() kullanılarak birleştirilir. Örneğin, bir film önerisi modelinde xu kullanıcı özelliklerini, xv ise film özelliklerini ifade eder.

Bu tür modeller, kullanıcı ve kullanıcı olmayan özellikleri ayırdıkları için yukarıda bahsedilen dağıtılmış sistem mimarisine uygundur.

Faktörize edilmiş modeller, Diferansiyel Gizlilikli Alternatif Minimizasyon (DPAM) kullanılarak eğitilir. Bu yöntem, parametreleri θu (θv sabitken) ve tersi yönde optimize etme arasında geçiş yapar. DPAM algoritmalarının, özellikle herkese açık özelliklerin kullanıldığı çeşitli ayarlarda daha iyi bir fayda sağladığı gösterilmiştir 4 11.

Referanslar

- 1: Dwork et al. Calibrating Noise to Sensitivity in Private Data Analysis, TCC'06

- 2: ABD Nüfus Sayım Bürosu. Understanding Differential Privacy, 2020 (Diferansiyel Gizliliği Anlama, 2020)

- 3: Federated Learning with Formal Differential Privacy Guarantees, Google AI Blog Post, 2020 (Resmi Diferansiyel Gizlilik Garantileriyle Birleştirilmiş Öğrenme, Google Yapay Zeka Blog Yayını, 2020)

- 4: Jain et al. Differentially Private Model Personalization, NeurIPS'21

- 5: Krichene ve diğerleri, Private Learning with Public Features, 2023

- 6: Song et al. Stochastic gradient descent with differentially private updates, GlobalSIP'13

- 7: Differentially Private Empirical Risk Minimization: Efficient Algorithms and Tight Error Bounds, FOCS'14

- 8: Abadi et al. Deep Learning with Differential Privacy, CCS '16

- 9: Smith et al. (Nearly) Optimal Algorithms for Private Online Learning in Full-information and Bandit Settings, NeurIPS'13

- 10: Kairouz ve diğerleri, Practical and Private (Deep) Learning without Sampling or Shuffling, ICML'21

- 11: Chien et al. Private Alternating Least Squares, ICML'21