В этом документе обобщается подход к обеспечению конфиденциальности при персонализации на устройстве (ODP) в контексте дифференциальной конфиденциальности. Другие аспекты конфиденциальности и проектные решения, такие как минимизация данных, намеренно опущены, чтобы сохранить фокус документа на главном.

Дифференцированная конфиденциальность

Дифференцированная конфиденциальность¹ — широко распространенный стандарт защиты конфиденциальности в статистическом анализе данных и машинном обучении² ³ . Неформально это означает, что злоумышленник узнает о пользователе практически одно и то же из результатов работы алгоритма с дифференциальной конфиденциальностью независимо от того, присутствует ли его запись в базовом наборе данных или нет. Это подразумевает надежную защиту отдельных лиц: любые выводы о человеке могут быть сделаны только на основе совокупных свойств набора данных, которые были бы справедливы как с записью этого человека, так и без нее.

В контексте машинного обучения выходные данные алгоритма следует рассматривать как параметры обученной модели. Фраза «почти то же самое» математически выражается двумя параметрами (ε, δ), где ε обычно выбирается как небольшая константа, а δ≪1/(количество пользователей).

Семантика конфиденциальности

В основе архитектуры ODP лежит обеспечение дифференциальной приватности на уровне (ε,δ) пользователей для каждого запуска обучения. Ниже описан наш подход к достижению этой семантики.

модель угроз

Мы определяем различные стороны и излагаем предположения относительно каждой из них:

- Пользователь: Пользователь, которому принадлежит устройство и который является потребителем продуктов или услуг, предоставляемых разработчиком. Его личная информация полностью доступна ему самому.

- Доверенная среда выполнения (TEE): Данные и доверенные вычисления, происходящие внутри TEE, защищены от злоумышленников с помощью различных технологий. Поэтому вычисления и данные не требуют дополнительной защиты. Существующие TEE могут предоставлять администраторам проектов доступ к содержащейся в них информации. Мы предлагаем пользовательские возможности для запрета и проверки недоступности доступа для администратора.

- Злоумышленник может обладать дополнительной информацией о пользователе и иметь полный доступ к любой информации, покидающей TEE (например, к опубликованным параметрам модели).

- Разработчик: Тот, кто определяет и обучает модель. Считается ненадежным (и обладает всеми возможностями злоумышленника).

Мы стремимся разработать ODP со следующей семантикой дифференциальной конфиденциальности:

- Граница доверия: С точки зрения пользователя, граница доверия состоит из его собственного устройства и TEE (Telephone Entry Entry). Любая информация, покидающая эту границу доверия, должна быть защищена дифференциальной конфиденциальностью.

- Злоумышленник: Полная защита от дифференцированной конфиденциальности по отношению к злоумышленнику. Любая сущность за пределами зоны доверия может быть злоумышленником (включая разработчика и других пользователей, потенциально вступающих в сговор). Злоумышленник, имея всю информацию за пределами зоны доверия (например, опубликованную модель), любую дополнительную информацию о пользователе и неограниченные ресурсы, не может получить дополнительные конфиденциальные данные о пользователе (помимо тех, которые уже содержатся в дополнительной информации) в пределах вероятности, заданной бюджетом конфиденциальности. В частности, это подразумевает полную защиту от дифференцированной конфиденциальности по отношению к разработчику. Любая информация, предоставленная разработчику (например, параметры обученной модели или агрегированные выводы), защищена от дифференцированной конфиденциальности.

Локальные параметры модели

Предыдущая семантика конфиденциальности учитывает случай, когда некоторые параметры модели являются локальными для устройства (например, модель, содержащая векторное представление пользователя, специфичное для каждого пользователя и не используемое другими пользователями). Для таких моделей эти локальные параметры остаются в пределах доверительной зоны (они не публикуются) и не требуют защиты, в то время как общие параметры модели публикуются (и защищаются дифференциальной конфиденциальностью). Иногда это называют моделью конфиденциальности «билборда» ⁴ .

Общедоступные функции

В некоторых приложениях часть характеристик является общедоступной. Например, в задаче рекомендации фильмов характеристики фильма (режиссер, жанр или год выпуска) являются общедоступной информацией и не требуют защиты, в то время как характеристики, связанные с пользователем (например, демографическая информация или список просмотренных фильмов), являются частными данными и требуют защиты.

Общедоступная информация формализуется в виде общедоступной матрицы признаков (в предыдущем примере эта матрица содержала бы одну строку на каждый фильм и один столбец на каждый признак фильма), которая доступна всем сторонам. Алгоритм обучения с дифференциальной приватностью может использовать эту матрицу без необходимости ее защиты, см., например, 5. Платформа ODP планирует реализовать такие алгоритмы.

Подход к обеспечению конфиденциальности при прогнозировании или выводе заключений.

Выводы основаны на параметрах модели и входных признаках. Параметры модели обучаются с использованием семантики дифференциальной конфиденциальности. Здесь обсуждается роль входных признаков.

В некоторых случаях, когда разработчик уже имеет полный доступ к функциям, используемым в процессе вывода, проблем с конфиденциальностью, связанных с выводом, нет, и результат вывода может быть виден разработчику.

В других случаях (когда используемые в процессе вывода функции являются частными и недоступны разработчику) результат вывода может быть скрыт от разработчика, например, путем выполнения вывода (и любого последующего процесса, использующего результат вывода) на устройстве, в процессе, принадлежащем операционной системе, и в области отображения, с ограниченным обменом данными за пределами этого процесса.

Процедура обучения

Обзор

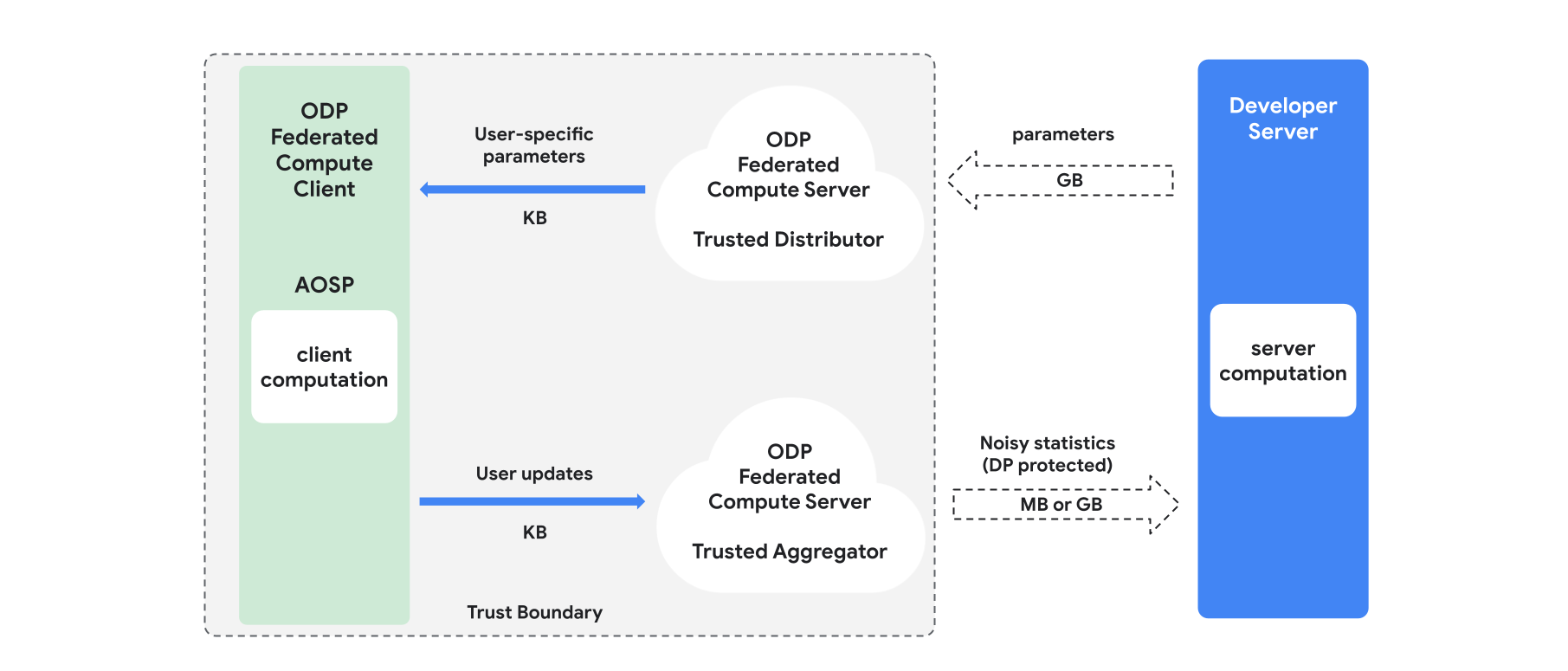

В этом разделе представлен обзор архитектуры и процесса обучения (см. рис. 1). ODP реализует следующие компоненты:

Доверенный дистрибьютор, такой как федеративный выбор, доверенная загрузка или получение частной информации, играет роль широковещательного канала передачи параметров модели. Предполагается, что доверенный дистрибьютор может отправлять каждому клиенту подмножество параметров, не раскрывая, какие параметры были загружены каким клиентом. Такая «частичная широковещательная передача» позволяет системе минимизировать нагрузку на устройство конечного пользователя: вместо отправки полной копии модели, каждому пользователю отправляется лишь часть параметров модели.

Надежный агрегатор, который собирает информацию от нескольких клиентов (например, градиенты или другие статистические данные), добавляет шум и отправляет результат на сервер. Предполагается наличие надежных каналов связи между клиентом и агрегатором, а также между клиентом и дистрибьютором.

Алгоритмы обучения DP, работающие на этой инфраструктуре. Каждый алгоритм обучения состоит из различных вычислений, выполняемых на разных компонентах (сервер, клиент, агрегатор, дистрибьютор).

Типичный курс обучения состоит из следующих этапов:

- Сервер передает параметры модели доверенному дистрибьютору.

- Вычисления клиента

- Каждое клиентское устройство получает широковещательную модель (или подмножество параметров, имеющих отношение к пользователю).

- Каждый клиент выполняет некоторые вычисления (например, вычисляет градиенты или другие достаточные статистики).

- Каждый клиент отправляет результат вычислений доверенному агрегатору.

- Надежный агрегатор собирает, агрегирует и защищает статистические данные от клиентов с помощью соответствующих механизмов дифференциальной конфиденциальности, а затем отправляет результат на сервер.

- Вычисления сервера

- (Ненадежный) сервер выполняет вычисления на основе статистических данных, защищенных с помощью дифференциальной конфиденциальности (например, использует агрегированные градиенты с дифференциальной конфиденциальностью для обновления параметров модели).

Факторизованные модели и дифференциально-приватная чередующаяся минимизация

Платформа ODP планирует предоставлять универсальные алгоритмы обучения с дифференциальной приватностью, которые могут применяться к любой архитектуре модели (например, DP-SGD 6 7 8 или DP-FTRL 9 10) , а также алгоритмы, специализированные для факторизованных моделей.

Факторизованные модели — это модели, которые можно разложить на подмодели (называемые кодировщиками или башнями). Например, рассмотрим модель вида f(u(θu, xu), v(θv, xv)) , где u() кодирует характеристики пользователя xu (и имеет параметры θu ), а v() кодирует характеристики, не относящиеся к пользователю, xv (и имеет параметры θv ). Два кодирования объединяются с помощью f() для получения окончательного предсказания модели. Например, в модели рекомендаций фильмов xu — это характеристики пользователя, а xv — характеристики фильма.

Подобные модели хорошо подходят для вышеупомянутой архитектуры распределенной системы (поскольку они разделяют функции пользователя и непользователя).

Факторизованные модели будут обучаться с использованием алгоритма дифференциально-приватной чередующейся минимизации (DPAM), который чередует оптимизацию параметров θu (при фиксированном θv ) и наоборот. Было показано, что алгоритмы DPAM обеспечивают лучшую эффективность в различных условиях 4 11 , в частности, при наличии общедоступных признаков.

Ссылки

- 1 : Дворк и др. Калибровка шума в зависимости от чувствительности при анализе частных данных, TCC'06

- 2 : Бюро переписи населения США. Понимание дифференциальной конфиденциальности, 2020 год.

- 3 : Федеративное обучение с формальными гарантиями дифференциальной конфиденциальности, сообщение в блоге Google AI, 2020 г.

- 4 : Джайн и др. Персонализация модели с дифференциальной приватностью, NeurIPS'21

- 5 : Кричене и др. Частное обучение с общедоступными функциями, 2023 г.

- 6 : Сонг и др. Стохастический градиентный спуск с обновлениями с дифференциальной приватностью, GlobalSIP'13

- 7 : Минимизация эмпирического риска с учетом дифференцированной конфиденциальности: эффективные алгоритмы и жесткие границы погрешности, FOCS'14

- 8 : Абади и др. Глубокое обучение с дифференциальной конфиденциальностью, CCS '16

- 9 : Смит и др. (Почти) оптимальные алгоритмы для частного онлайн-обучения в условиях полной информации и многорукого бандита, NeurIPS'13

- 10 : Кайруз и др., Практическое и приватное (глубокое) обучение без выборки или перемешивания, ICML'21

- 11 : Чиен и др. Частный метод чередующихся наименьших квадратов, ICML'21