يلخّص هذا المستند نهج الخصوصية المتّبع في ميزة "التخصيص على الجهاز" (ODP)، وتحديدًا في سياق الخصوصية التفاضلية. تم استبعاد الآثار الأخرى المتعلقة بالخصوصية وقرارات التصميم، مثل تقليل البيانات إلى الحد الأدنى، عمدًا للحفاظ على تركيز هذا المستند.

الخصوصية التفاضلية

الخصوصية التفاضلية 1 هي معيار معتمَد على نطاق واسع لحماية الخصوصية في تحليل البيانات الإحصائية وتعلُّم الآلة 2 3. بشكل غير رسمي، تنصّ على أنّ الخصم يتعرّف على المعلومات نفسها تقريبًا عن المستخدم من ناتج خوارزمية الخصوصية التفاضلية سواء ظهر سجله في مجموعة البيانات الأساسية أم لا. ويشير ذلك إلى توفير حماية قوية للأفراد: لا يمكن استنتاج أي معلومات عن شخص إلا بسبب الخصائص المجمّعة لمجموعة البيانات التي يمكن أن تتضمّن سجلّ هذا الشخص أو لا تتضمّنه.

في سياق تعلُّم الآلة، يجب اعتبار ناتج الخوارزمية على أنّه مَعلمات النموذج المدرَّب. يتم تحديد عبارة تقريبًا الشيء نفسه رياضيًا من خلال مَعلمتَين (ε، δ)، حيث يتم عادةً اختيار ε ليكون ثابتًا صغيرًا، وδ≪1/(عدد المستخدمين).

دلالات الخصوصية

يهدف تصميم ODP إلى ضمان أنّ كل عملية تدريب تكون (ε,δ)-user level differentially private. في ما يلي توضيح لنهجنا في الوصول إلى هذا المعنى الدلالي.

نموذج التهديد

نحدّد الجهات المختلفة ونذكر الافتراضات المتعلّقة بكل جهة:

- المستخدم: هو الشخص الذي يملك الجهاز ويستهلك المنتجات أو الخدمات التي يقدّمها المطوّر. ويمكنهم الاطّلاع على معلوماتهم الخاصة بالكامل.

- بيئة التنفيذ الموثوقة (TEE): يتم حماية البيانات والحسابات الموثوقة التي تتم داخل بيئات التنفيذ الموثوقة من المهاجمين باستخدام مجموعة متنوّعة من التقنيات. وبالتالي، لا تتطلّب العمليات الحسابية والبيانات أي حماية إضافية. قد تسمح بيئات التنفيذ الموثوقة الحالية لمشرفي المشاريع بالوصول إلى المعلومات بداخلها. نقترح إمكانات مخصّصة لمنع وصول المشرفين إلى البيانات والتحقّق من عدم توفّرها لهم.

- المهاجم: قد تتوفر لديه معلومات جانبية عن المستخدم و يمكنه الوصول بشكل كامل إلى أي معلومات تخرج من بيئة التنفيذ الموثوقة (مثل مَعلمات النموذج المنشور).

- المطوّر: هو الشخص الذي يحدّد النموذج ويدرّبه. يُعدّ غير موثوق به (ويتمتّع بكامل قدرات المهاجم).

نسعى إلى تصميم ODP باستخدام دلالات الخصوصية التفاضلية التالية:

- حدود الثقة: من منظور أحد المستخدمين، تتألف حدود الثقة من جهاز المستخدم الخاص بالإضافة إلى بيئة التنفيذ الموثوقة (TEE). يجب حماية أي معلومات تخرج من حدود الثقة هذه باستخدام الخصوصية التفاضلية.

- المهاجم: توفير حماية كاملة للخصوصية التفاضلية في ما يتعلّق بالمهاجم يمكن أن يكون أي كيان خارج حدود الثقة مهاجمًا (ويشمل ذلك المطوّر والمستخدمين الآخرين، وكلهم قد يتآمرون). إذا توفّرت للمهاجم جميع المعلومات خارج حدود الثقة (مثل النموذج المنشور)، وأي معلومات جانبية عن المستخدم، وموارد غير محدودة، لن يتمكّن من استنتاج بيانات خاصة إضافية عن المستخدم (بخلاف تلك المتوفّرة في المعلومات الجانبية)، وذلك وفقًا للاحتمالات التي يحدّدها سقف الخصوصية. ويشير ذلك على وجه الخصوص إلى توفير حماية كاملة للخصوصية التفاضلية فيما يتعلق بالمطوّر. تكون أي معلومات يتم إتاحتها للمطوّر (مثل مَعلمات النموذج المدرَّب أو الاستنتاجات المجمَّعة) محمية باستخدام الخصوصية التفاضلية.

مَعلمات النموذج على الجهاز

تتيح دلالات الخصوصية السابقة الحالة التي تكون فيها بعض مَعلمات النموذج محلية على الجهاز (على سبيل المثال، نموذج يحتوي على تضمين مستخدم خاص بكل مستخدم، ولا تتم مشاركته بين المستخدمين). بالنسبة إلى هذه النماذج، تبقى المَعلمات المحلية ضمن حدود الثقة (ولا يتم نشرها) ولا تتطلّب أي حماية، بينما يتم نشر مَعلمات النموذج المشترَكة (وتتم حمايتها من خلال الخصوصية التفاضلية). يُشار إلى ذلك أحيانًا باسم نموذج الخصوصية الخاص بلوحات الإعلانات 4.

الميزات المتاحة للجميع

في بعض التطبيقات، تكون بعض الميزات متاحة للجميع. على سبيل المثال، في مشكلة اقتراح الأفلام، تكون ميزات الفيلم (مثل المخرج أو النوع أو سنة الإصدار) معلومات عامة ولا تتطلّب الحماية، بينما تكون الميزات المتعلّقة بالمستخدم (مثل المعلومات الديمغرافية أو الأفلام التي شاهدها المستخدم) بيانات خاصة وتتطلّب الحماية.

يتم تنظيم المعلومات العامة في مصفوفة ميزات عامة (في المثال السابق، ستتضمّن هذه المصفوفة صفًا واحدًا لكل فيلم وعمودًا واحدًا لكل ميزة من ميزات الفيلم)، وتكون متاحة لجميع الأطراف. يمكن لخوارزمية التدريب التي تحافظ على الخصوصية التفاضلية الاستفادة من هذه المصفوفة بدون الحاجة إلى حمايتها، راجِع على سبيل المثال 5. تخطّط منصة ODP لتنفيذ هذه الخوارزميات.

نهج بشأن الخصوصية أثناء التنبؤ أو الاستنتاج

تستند الاستنتاجات إلى مَعلمات النموذج وميزات الإدخال. يتم تدريب مَعلمات النموذج باستخدام دلالات الخصوصية التفاضلية. في هذا القسم، نناقش دور ميزات الإدخال.

في بعض حالات الاستخدام، عندما يكون لدى المطوّر إذن وصول كامل إلى الميزات المستخدَمة في الاستنتاج، لا يكون هناك أيّ مخاوف بشأن الخصوصية من الاستنتاج، وقد يكون بإمكان المطوّر الاطّلاع على نتيجة الاستنتاج.

في حالات أخرى (عندما تكون الميزات المستخدَمة في الاستنتاج خاصة ولا يمكن للمطوّر الوصول إليها)، قد يتم إخفاء نتيجة الاستنتاج عن المطوّر، مثلاً من خلال تنفيذ الاستنتاج (وأي عملية لاحقة تستخدم نتيجة الاستنتاج) على الجهاز، في عملية ومنطقة عرض تملكهما نظام التشغيل، مع تقييد التواصل خارج هذه العملية.

إجراء التدريب

نظرة عامة

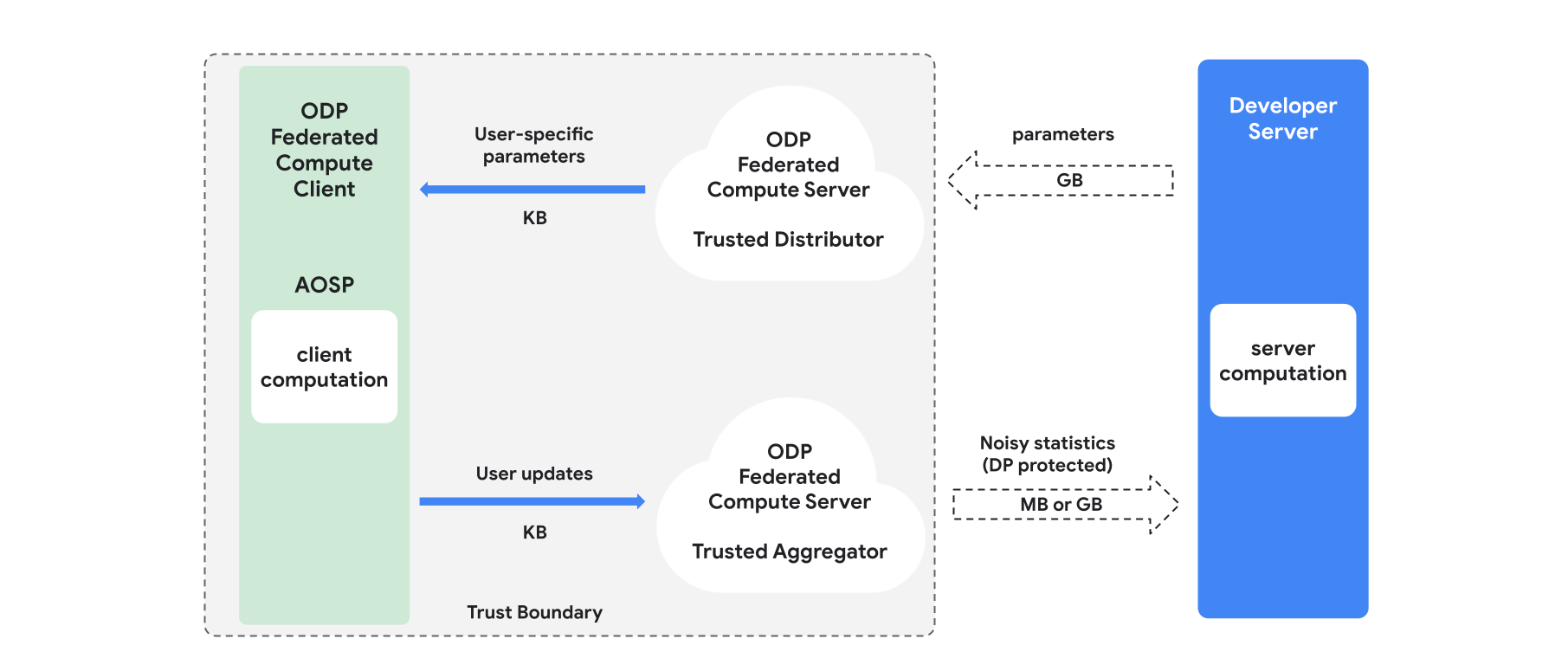

يقدم هذا القسم نظرة عامة على البنية وكيفية إجراء التدريب، كما هو موضّح في الشكل 1. تتضمّن منصة ODP المكوّنات التالية:

موزّع موثوق به، مثل federated select أو trusted download أو private information retrieval، يؤدي دور بث مَعلمات النموذج. يُفترض أنّ الموزّع الموثوق به يمكنه إرسال مجموعة فرعية من المَعلمات إلى كل عميل، بدون الكشف عن المَعلمات التي نزّلها كل عميل. تتيح هذه "البث الجزئي" للنظام تقليل تأثيره على جهاز المستخدم النهائي: فبدلاً من إرسال نسخة كاملة من النموذج، يتم إرسال جزء فقط من مَعلمات النموذج إلى أي مستخدم.

أداة تجميع موثوقة تجمع المعلومات من عدة عملاء (مثل التدرجات أو الإحصاءات الأخرى)، وتضيف تشويشًا، وترسل النتيجة إلى الخادم. ويُفترض أنّ هناك قنوات موثوقة بين العميل والمجمّع، وبين العميل والموزّع.

خوارزميات التدريب على الخصوصية التفاضلية التي تعمل على هذه البنية الأساسية تتألف كل خوارزمية تدريب من عمليات حسابية مختلفة يتم تنفيذها على المكوّنات المختلفة (الخادم والعميل والمجمّع والموزّع).

تتألف جولة التدريب النموذجية من الخطوات التالية:

- يبثّ الخادم مَعلمات النموذج إلى الموزّع الموثوق به.

- الحساب على الجهاز

- يتلقّى كل جهاز عميل النموذج الذي يتم بثّه (أو المجموعة الفرعية من المَعلمات ذات الصلة بالمستخدم).

- يُجري كل عميل بعض العمليات الحسابية (مثل حساب التدرجات أو الإحصاءات الكافية الأخرى).

- يرسل كل عميل نتيجة الحساب إلى خدمة التجميع الموثوقة.

- يجمع المجمّع الموثوق به الإحصاءات من الأجهزة العميلة ويجمّعها ويحميها باستخدام آليات الخصوصية التفاضلية المناسبة، ثم يرسل النتيجة إلى الخادم.

- الحوسبة على الخادم

- يُجري الخادم (غير الموثوق به) عمليات حسابية على الإحصاءات المحمية بالخصوصية التفاضلية (على سبيل المثال، يستخدم التدرّجات المجمّعة المحمية بالخصوصية التفاضلية لتعديل مَعلمات النموذج).

النماذج المحلَّلة والتقليل بالتناوب مع الحفاظ على الخصوصية التفاضلية

تخطّط منصة ODP لتوفير خوارزميات تدريب عامة الأغراض مع الحفاظ على الخصوصية التفاضلية، ويمكن تطبيقها على أي بنية نموذجية (مثل DP-SGD 6 7 8 أو DP-FTRL 9 10، بالإضافة إلى خوارزميات متخصّصة في نماذج محلّلة إلى عوامل.

النماذج المحلَّلة هي نماذج يمكن تقسيمها إلى نماذج فرعية (تُعرف باسم أدوات الترميز أو الأبراج). على سبيل المثال، لنفترض نموذجًا بالشكل f(u(θu, xu), v(θv, xv))، حيث يشفّر u() ميزات المستخدم xu (ويتضمّن المَعلمات θu)، ويشفّر v() ميزات غير خاصة بالمستخدم xv (ويتضمّن المَعلمات θv). يتم دمج الترميزَين باستخدام f() لإنتاج توقّع النموذج النهائي. على سبيل المثال، في نموذج اقتراحات الأفلام، xu هي ميزات المستخدم وxv هي ميزات الفيلم.

هذه النماذج مناسبة تمامًا لبنية الأنظمة الموزّعة المذكورة أعلاه (لأنّها تفصل بين ميزات المستخدمين وغير المستخدمين).

سيتم تدريب النماذج المحلَّلة باستخدام أسلوب "التقليل بالتناوب مع الحفاظ على الخصوصية التفاضلية" (DPAM)، والذي يتناوب بين تحسين المَعلمات θu (بينما تكون θv ثابتة) والعكس. لقد تبيّن أنّ خوارزميات DPAM تحقّق فائدة أفضل في مجموعة متنوعة من الإعدادات 4 11، لا سيما في حال توفّر ميزات عامة.

المراجع

- 1: Dwork et al. Calibrating Noise to Sensitivity in Private Data Analysis, TCC'06

- 2: مكتب الإحصاء الأمريكي التعرّف على الخصوصية التفاضلية، 2020

- 3: Federated Learning with Formal Differential Privacy Guarantees، مشاركة في مدونة Google AI، 2020

- 4: Jain et al. Differentially Private Model Personalization, NeurIPS'21

- 5: Krichene et al. Private Learning with Public Features, 2023

- 6: Song et al. Stochastic gradient descent with differentially private updates, GlobalSIP'13

- 7: Differentially Private Empirical Risk Minimization: Efficient Algorithms and Tight Error Bounds, FOCS'14

- 8: Abadi et al. Deep Learning with Differential Privacy, CCS '16

- 9: Smith et al. (Nearly) Optimal Algorithms for Private Online Learning in Full-information and Bandit Settings, NeurIPS'13

- 10: Kairouz et al., Practical and Private (Deep) Learning without Sampling or Shuffling, ICML'21

- 11: Chien et al. Private Alternating Least Squares, ICML'21