1. Предпосылки

Для выполнения этой Codelab требуется несколько предварительных условий. Каждое требование помечено соответствующим образом, требуется ли оно для "Local Testing" или "Aggregation Service".

1.1. Загрузите инструмент локального тестирования (локальное тестирование)

Локальное тестирование потребует загрузки Local Testing Tool. Инструмент сгенерирует сводные отчеты из незашифрованных отладочных отчетов.

Инструмент локального тестирования доступен для загрузки в архивах Lambda JAR в Github . Он должен называться LocalTestingTool_{version}.jar .

1.2. Убедитесь, что установлена JAVA JRE (локальная служба тестирования и агрегации)

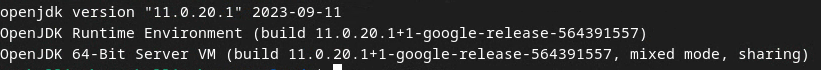

Откройте « Терминал » и используйте java --version , чтобы проверить, установлена ли на вашем компьютере Java или openJDK.

Проверка версии Java JRE с помощью `java --version`.

Проверка версии Java JRE с помощью `java --version`.

Если он не установлен, вы можете загрузить и установить его с сайта Java или сайта openJDK .

1.3. Загрузить конвертер агрегированных отчетов (локальная служба тестирования и агрегации)

Вы можете загрузить копию конвертера агрегированных отчетов из репозитория Privacy Sandbox Demos Github .

1.4. Включить API конфиденциальности рекламы (локальная служба тестирования и агрегации)

В браузере перейдите на страницу chrome://settings/adPrivacy и включите все API конфиденциальности рекламы.

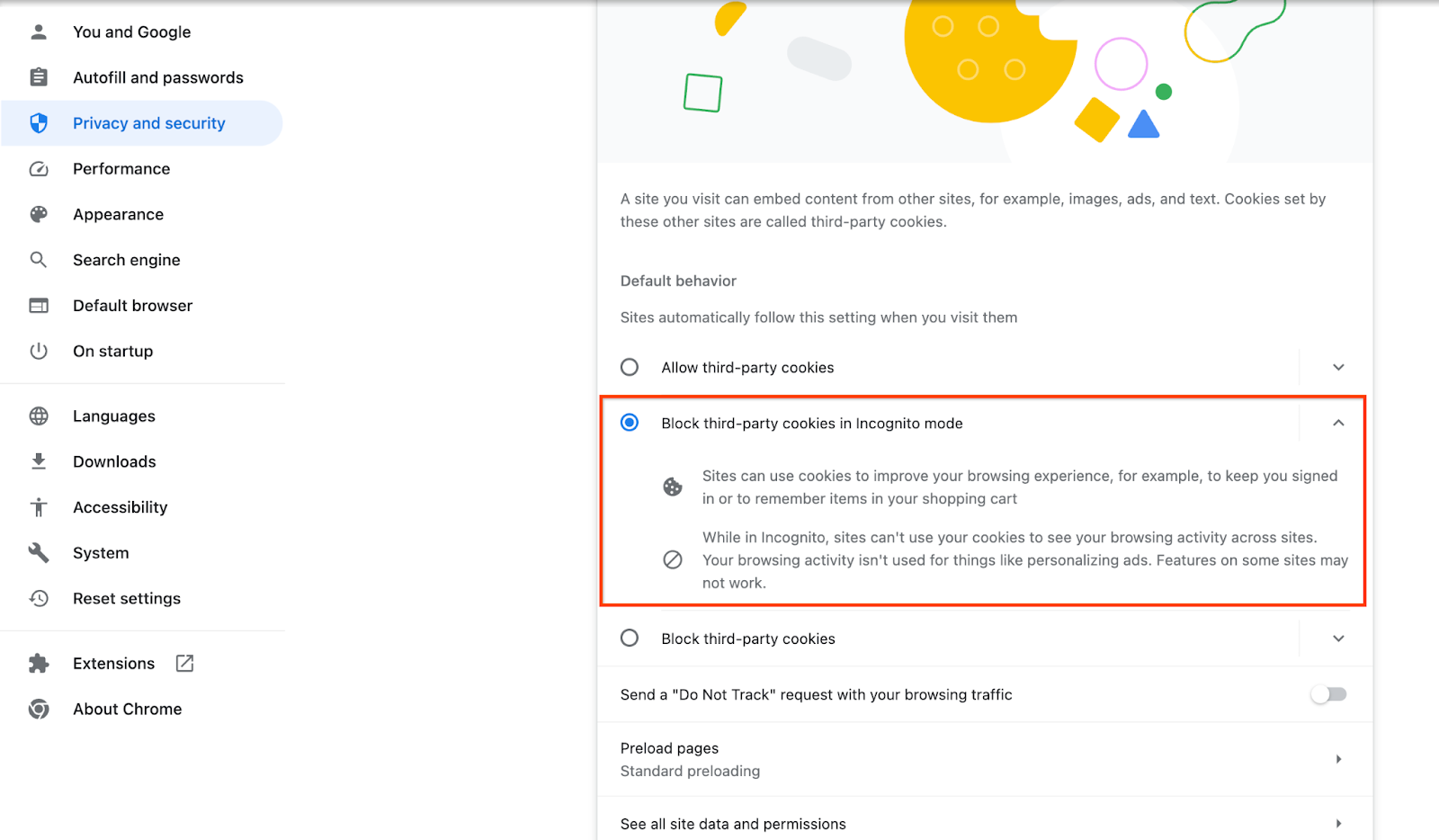

Убедитесь, что сторонние файлы cookie включены.

В браузере перейдите на страницу chrome://settings/cookies и выберите « Блокировать сторонние файлы cookie в режиме инкогнито ».

Настройка сторонних файлов cookie в Chrome.

Настройка сторонних файлов cookie в Chrome.

1.5. Регистрация через веб-сайт и Android (служба агрегации)

Чтобы использовать API Privacy Sandbox в производственной среде, убедитесь, что вы завершили регистрацию и аттестацию для Chrome и Android.

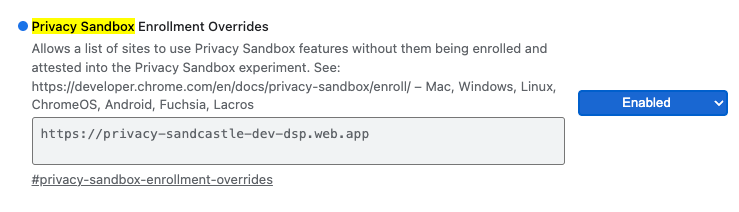

Для локального тестирования регистрацию можно отключить с помощью флага Chrome и переключателя CLI .

Чтобы использовать флаг Chrome для нашей демонстрации, перейдите по адресу chrome://flags/#privacy-sandbox-enrollment-overrides и обновите переопределение на своем сайте. Если же вы будете использовать наш демонстрационный сайт, то обновление не требуется.

Регистрация в изолированной среде конфиденциальности переопределяет флаг Chrome.

Регистрация в изолированной среде конфиденциальности переопределяет флаг Chrome.

1.6. Подключение службы агрегации (служба агрегации)

Aggregation Service требует подключения к координаторам, чтобы иметь возможность использовать сервис. Заполните форму подключения Aggregation Service , указав адрес вашего сайта отчетности, идентификатор учетной записи AWS и другую информацию.

1.7. Поставщик облачных услуг (служба агрегации)

Aggregation Service требует использования Trusted Execution Environment, которая использует облачную среду. Aggregation Service поддерживается в Amazon Web Services (AWS) и Google Cloud (GCP). Эта Codelab будет охватывать только интеграцию AWS.

AWS предоставляет Trusted Execution Environment, называемую Nitro Enclaves. Убедитесь, что у вас есть учетная запись AWS, и следуйте инструкциям по установке и обновлению AWS CLI , чтобы настроить среду AWS CLI.

Если у вас новый AWS CLI, вы можете настроить AWS CLI, используя инструкции по настройке CLI .

1.7.1.Создание контейнера AWS S3

Создайте AWS S3 Bucket для хранения состояния Terraform и еще один S3 Bucket для хранения отчетов и сводных отчетов. Вы можете использовать предоставленную команду CLI. Замените поле в <> на соответствующие переменные.

aws s3api create-bucket --bucket <tf_bucket_name> --region us-east-1

aws s3api create-bucket --bucket <report_bucket_name> --region us-east-1

1.7.2.Создание ключа доступа пользователя

Создайте ключи доступа пользователя с помощью руководства AWS . Это будет использоваться для вызова конечных точек API createJob и getJob , созданных на AWS.

1.7.3 Разрешения пользователей и групп AWS

Для развертывания Aggregation Service на AWS вам необходимо предоставить определенные разрешения пользователю, используемому для развертывания сервиса. Для этой Codelab убедитесь, что у пользователя есть доступ администратора, чтобы убедиться в полных разрешениях при развертывании.

1.8. Terraform (служба агрегации)

Эта практическая работа использует Terraform для развертывания Aggregation Service. Убедитесь, что двоичный файл Terraform установлен в вашей локальной среде.

Загрузите двоичный файл Terraform в свою локальную среду.

После загрузки двоичного файла Terraform извлеките файл и переместите двоичный файл Terraform в /usr/local/bin .

cp <directory>/terraform /usr/local/bin

Проверьте, доступен ли Terraform в classpath.

terraform -v

1.9. Почтальон (для агрегационного сервиса AWS)

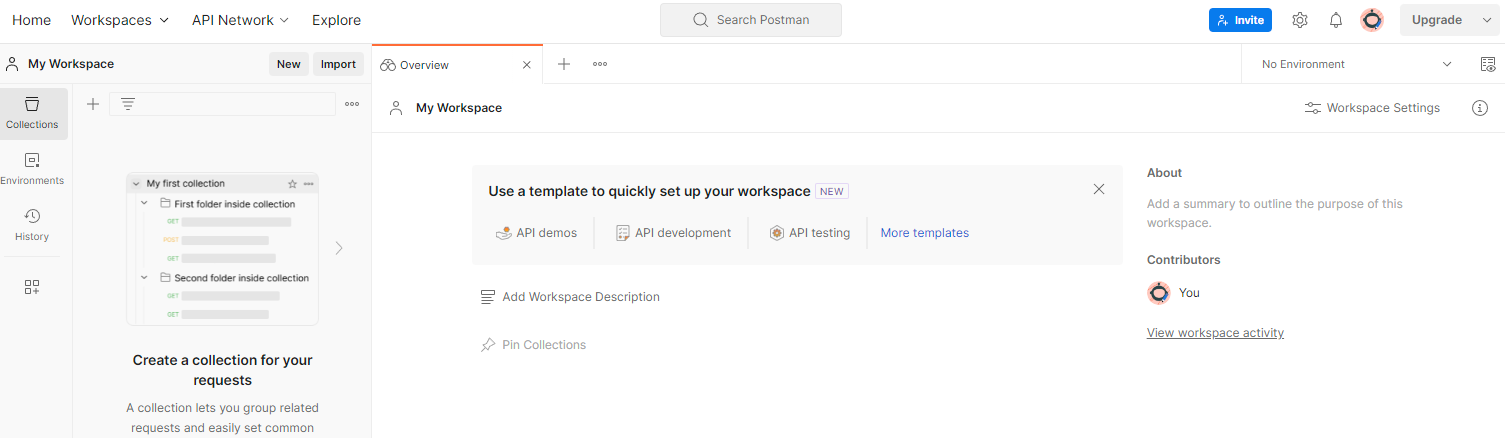

В этой лабораторной работе для управления запросами используйте Postman.

Создайте рабочее пространство, перейдя в верхний элемент навигации « Рабочие пространства » и выбрав « Создать рабочее пространство ».

Рабочее место почтальона

Рабочее место почтальона

Выберите « Пустое рабочее пространство », нажмите «Далее» и назовите его « Privacy Sandbox ». Выберите « Личное » и нажмите « Создать ».

Загрузите предварительно настроенную конфигурацию JSON рабочего пространства и файлы глобальной среды .

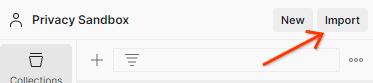

Импортируйте файлы JSON в « Мое рабочее пространство » с помощью кнопки « Импорт ».

Импортируйте файлы Postman JSON.

Импортируйте файлы Postman JSON.

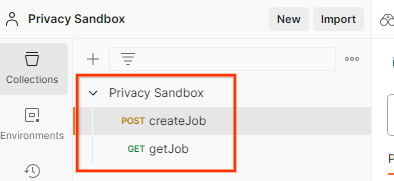

Это создаст для вас коллекцию Privacy Sandbox вместе с HTTP-запросами createJob и getJob .

Почтальон импортировал коллекцию.

Почтальон импортировал коллекцию.

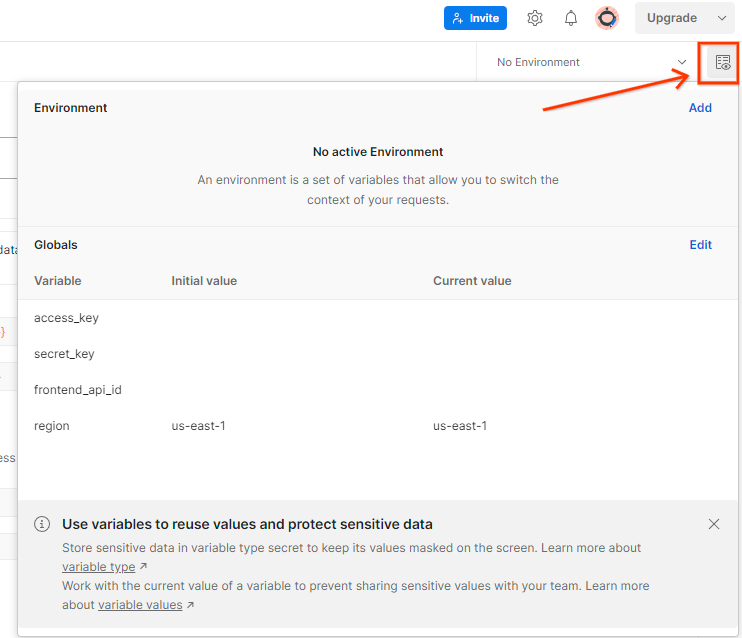

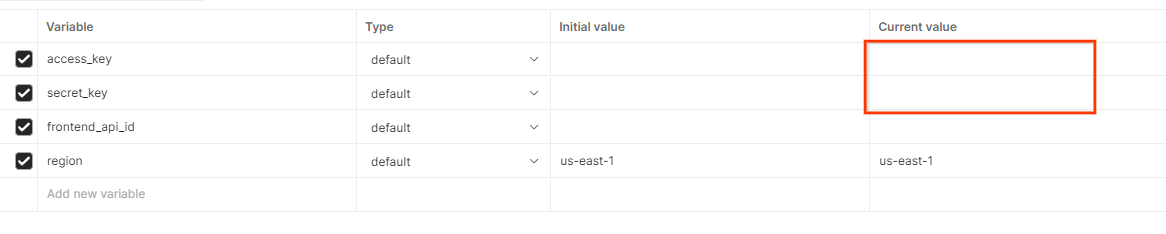

Обновите «Ключ доступа» и «Секретный ключ» AWS с помощью « Краткого обзора среды ».

Краткий обзор среды почтальона.

Краткий обзор среды почтальона.

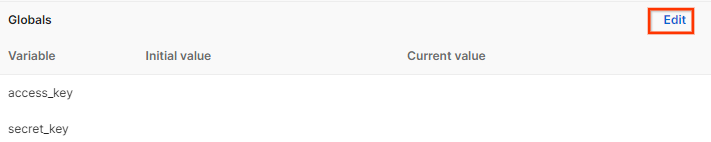

Нажмите « Изменить » и обновите «Текущее значение» для « access_key » и « secret_key ». Обратите внимание, что frontend_api_id будет предоставлен в разделе 3.1.4 этого документа. И мы рекомендуем использовать регион us-east-1. Однако, если вы хотите выполнить развертывание в другом регионе, убедитесь, что вы скопировали выпущенный AMI в свою учетную запись или выполните самостоятельную сборку с помощью предоставленных скриптов .

Глобальные переменные Postman.

Глобальные переменные Postman.  Postman редактирует глобальные переменные.

Postman редактирует глобальные переменные.

2. Локальная лабораторная работа по тестированию

Вы можете использовать локальный инструмент тестирования на своем компьютере для выполнения агрегации и создания сводных отчетов с использованием незашифрованных отладочных отчетов.

Шаги Codelab

Шаг 2.1. Запуск отчета : запуск частного агрегирования отчетов для возможности сбора отчета.

Шаг 2.2. Создание отладочного агрегированного отчета : преобразование собранного отчета JSON в отчет в формате AVRO.

Этот шаг будет аналогичен тому, как специалисты по рекламе собирают отчеты с конечных точек отчетов API и преобразуют отчеты JSON в отчеты в формате AVRO.

Шаг 2.3. Разберите ключ контейнера из отладочного отчета : ключи контейнера разработаны специалистами по рекламе. В этой кодовой лаборатории, поскольку контейнеры предопределены, извлеките ключи контейнера, как указано.

Шаг 2.4. Создайте выходной домен AVRO : После получения ключей контейнера создайте файл выходного домена AVRO.

Шаг 2.5. Создание сводных отчетов с помощью локального инструмента тестирования : используйте локальный инструмент тестирования, чтобы иметь возможность создавать сводные отчеты в локальной среде.

Шаг 2.6. Просмотрите сводный отчет : просмотрите сводный отчет, созданный локальным инструментом тестирования.

2.1. Отчет о триггере

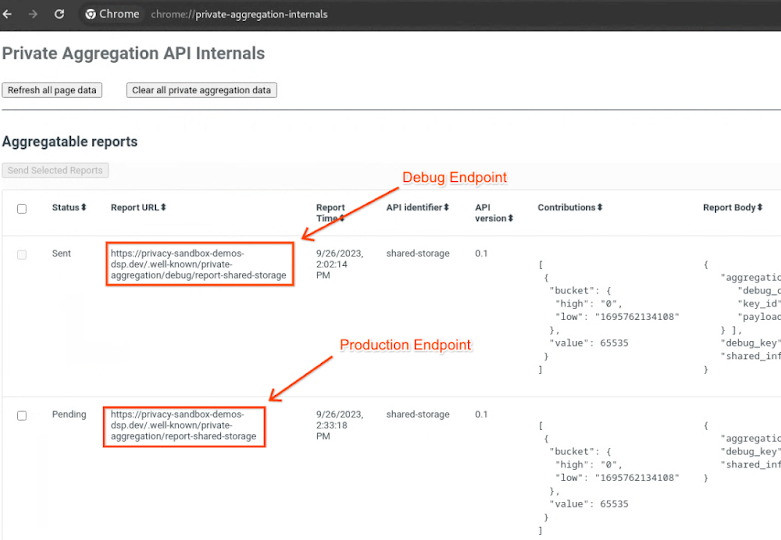

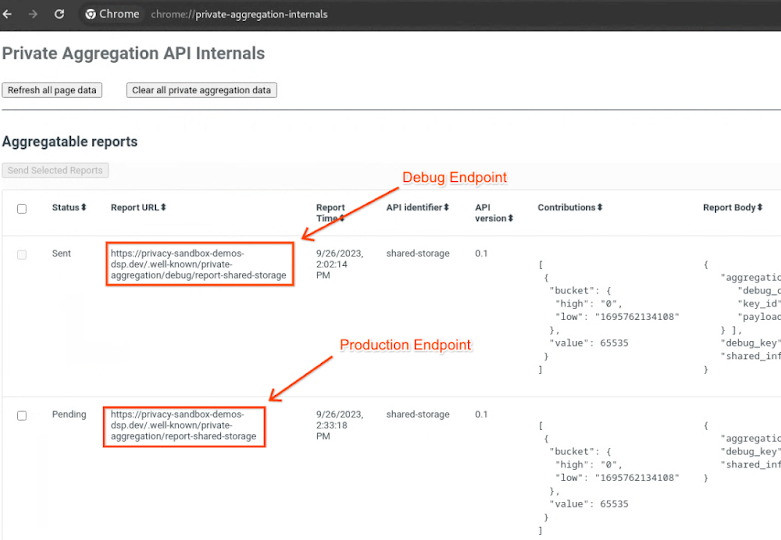

Перейдите на демонстрационный сайт Privacy Sandbox . Это запускает отчет о приватной агрегации. Вы можете просмотреть отчет по адресу chrome://private-aggregation-internals .

Внутренние компоненты частной агрегации Chrome.

Внутренние компоненты частной агрегации Chrome.

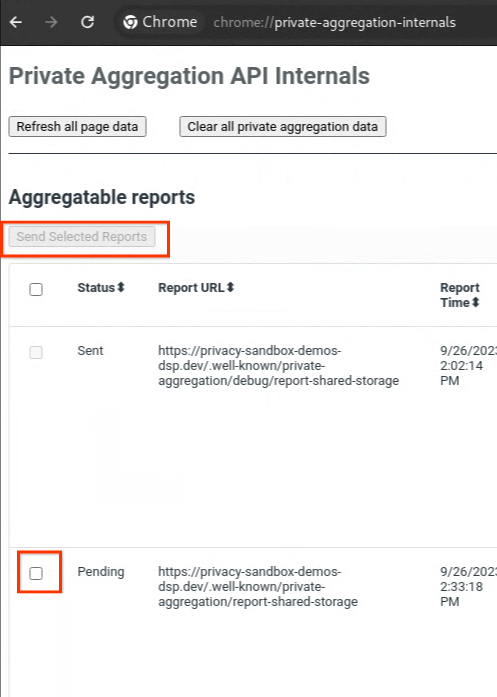

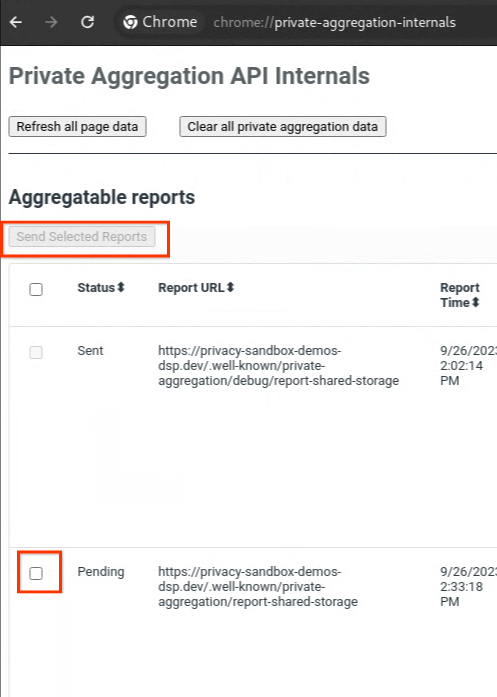

Если ваш отчет находится в статусе « Ожидание », вы можете выбрать отчет и нажать « Отправить выбранные отчеты ».

Отправить частный отчет по агрегации.

Отправить частный отчет по агрегации.

2.2. Создание отладочного агрегированного отчета

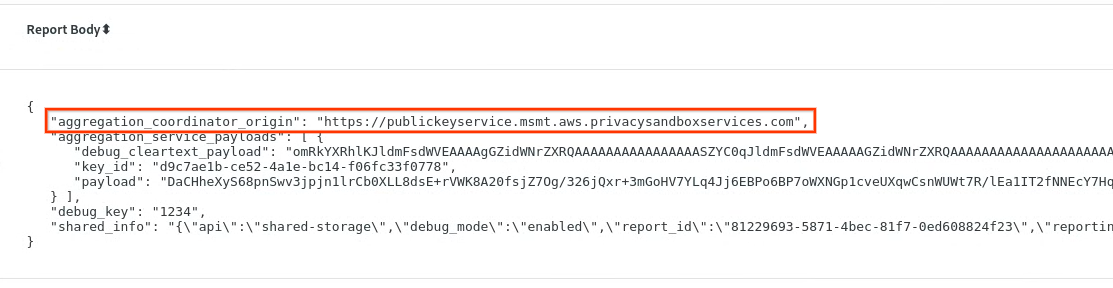

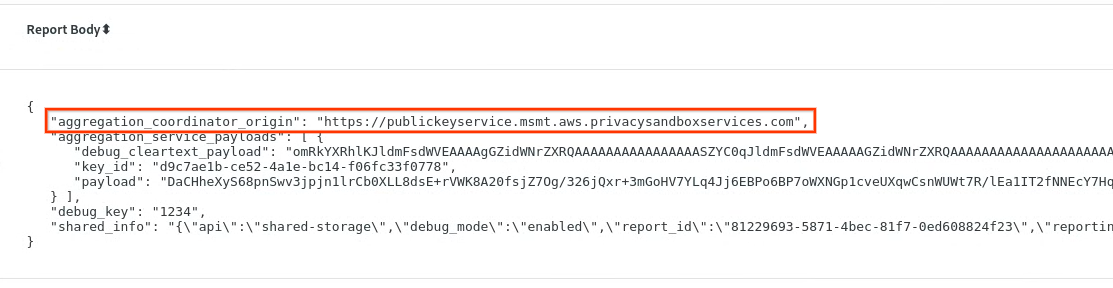

В chrome://private-aggregation-internals скопируйте « Тело отчета », полученное в конечной точке [reporting-origin]/.well-known/private-aggregation/report-shared-storage .

Убедитесь, что в поле « Тело отчета » параметр aggregation_coordinator_origin содержит https://publickeyservice.msmt.aws.privacysandboxservices.com , что означает, что отчет является агрегируемым отчетом AWS.

Частный отчет по агрегации.

Частный отчет по агрегации.

Поместите JSON " Report Body " в файл JSON. В этом примере вы можете использовать vim. Но вы можете использовать любой текстовый редактор, который вам нравится.

vim report.json

Вставьте отчет в report.json и сохраните файл.

Отчет в формате JSON.

Отчет в формате JSON.

После этого перейдите в папку с отчетами и используйте aggregatable_report_converter.jar , чтобы помочь создать отладочный агрегируемый отчет. Это создаст агрегируемый отчет с именем report.avro в вашем текущем каталоге.

java -jar aggregatable_report_converter.jar \

--request_type convertToAvro \

--input_file report.json \

--debug

2.3. Анализ ключа контейнера из отладочного отчета

Службе агрегации требуются два файла при пакетной обработке. Агрегируемый отчет и файл выходного домена. Файл выходного домена содержит ключи, которые вы хотите извлечь из агрегируемых отчетов. Для создания файла output_domain.avro вам понадобятся ключи контейнера, которые можно извлечь из отчетов.

Ключи контейнера проектируются вызывающей стороной API, а демо содержит предварительно сконструированные примеры ключей контейнера. Поскольку демо включило режим отладки для Private Aggregation, вы можете проанализировать полезную нагрузку debug cleartext из " Report Body ", чтобы получить ключ контейнера. Однако в этом случае демо-версия песочницы конфиденциальности сайта создает ключи контейнера. Поскольку частная агрегация для этого сайта находится в режиме отладки, вы можете использовать debug_cleartext_payload из " Report Body ", чтобы получить ключ контейнера.

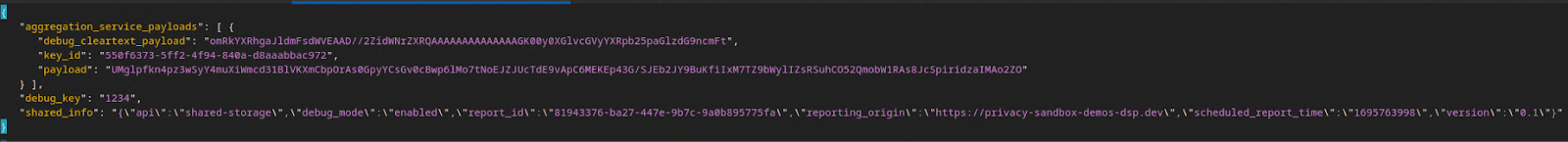

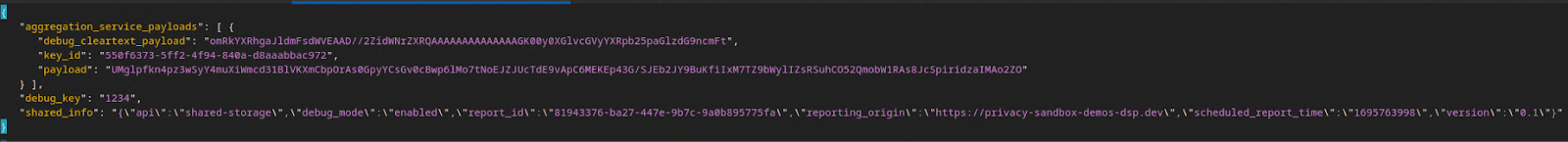

Скопируйте debug_cleartext_payload из тела отчета.

Отладка полезной нагрузки в открытом виде из тела отчета.

Отладка полезной нагрузки в открытом виде из тела отчета.

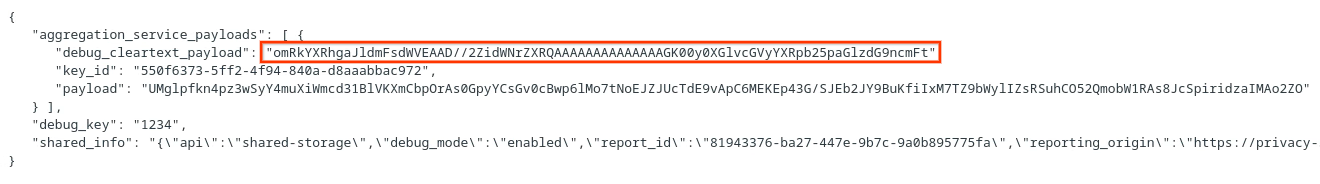

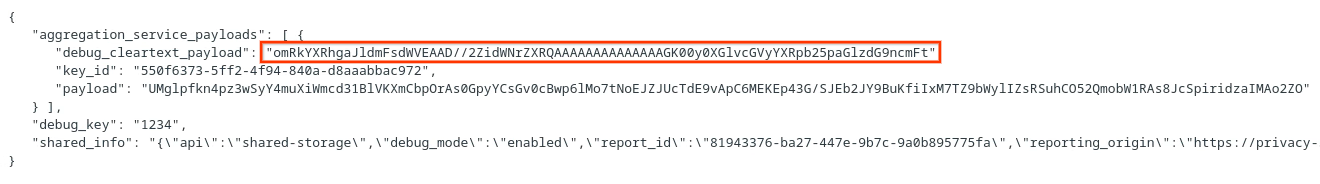

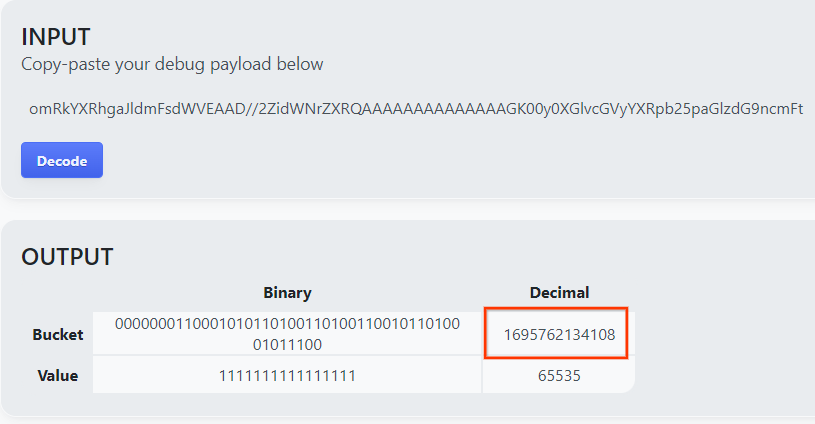

Откройте инструмент Debug payload decoder for Private Aggregation , вставьте debug_cleartext_payload в поле « INPUT » и нажмите « Decode ».

Декодер полезной нагрузки.

Декодер полезной нагрузки.

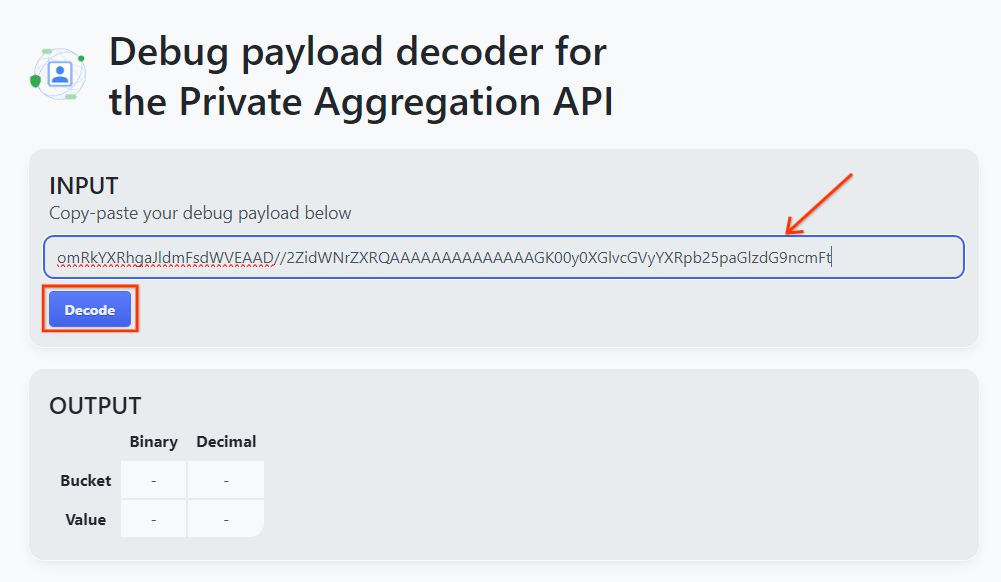

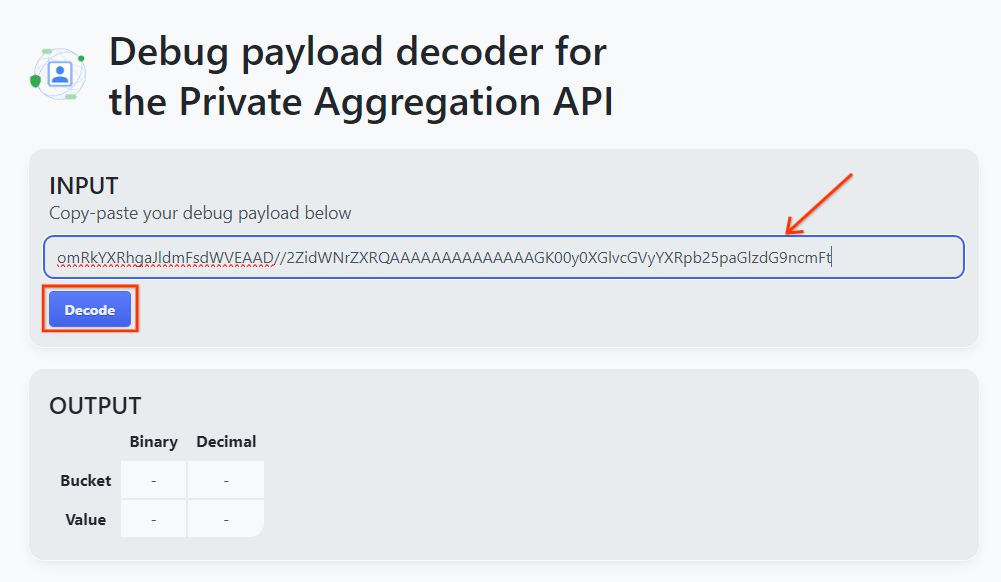

Страница возвращает десятичное значение ключа контейнера. Ниже приведен пример ключа контейнера.

Результат декодирования полезной нагрузки.

Результат декодирования полезной нагрузки.

2.4. Создайте выходной домен AVRO

Теперь, когда у нас есть ключ контейнера, скопируйте десятичное значение ключа контейнера. Продолжайте создавать output_domain.avro , используя ключ контейнера. Убедитесь, что вы заменили

java -jar aggregatable_report_converter.jar \

--request_type createDomainAvro \

--bucket_key <bucket key>

Скрипт создает файл output_domain.avro в вашей текущей папке.

2.5. Создание сводных отчетов с использованием инструмента локального тестирования

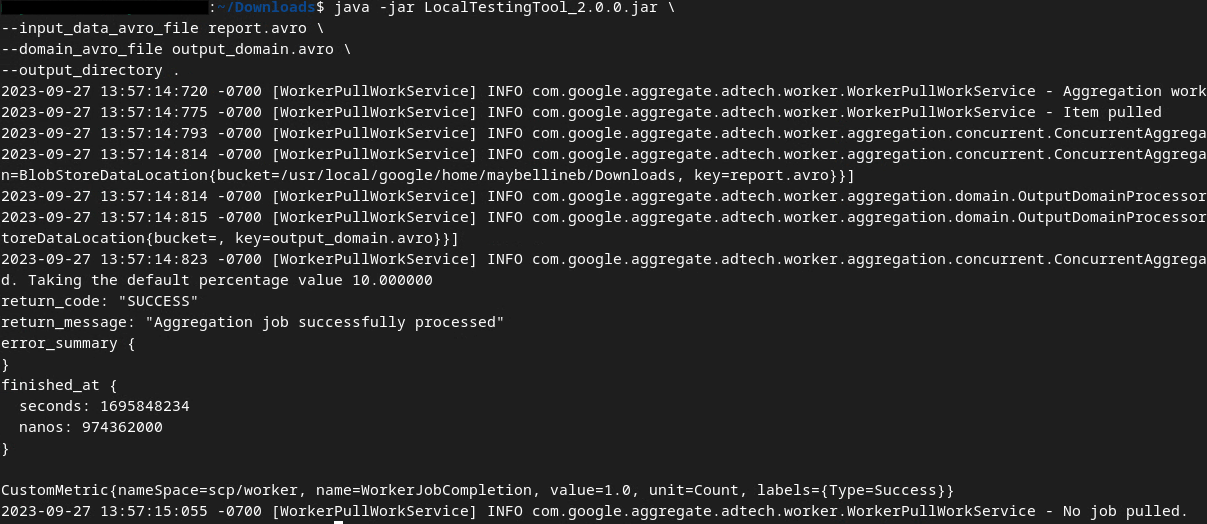

Мы будем использовать LocalTestingTool_{version}.jar , который был загружен в разделе 1.1, для создания сводных отчетов. Используйте следующую команду. Вам следует заменить LocalTestingTool_{version}.jar на версию, загруженную для LocalTestingTool.

Выполните следующую команду, чтобы создать сводный отчет в локальной среде разработки:

java -jar LocalTestingTool_{version}.jar \

--input_data_avro_file report.avro \

--domain_avro_file output_domain.avro \

--output_directory .

После запуска команды вы должны увидеть что-то похожее на следующее изображение. После завершения этой команды создается отчет output.avro .

Сводный отчет о локальном тестировании в формате avro.

Сводный отчет о локальном тестировании в формате avro.

2.6. Просмотрите сводный отчет.

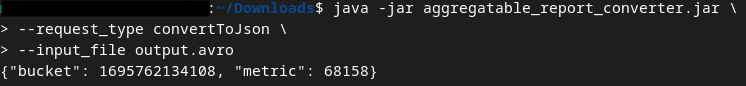

Сводный отчет, который создается, находится в формате AVRO. Чтобы иметь возможность прочитать его, вам нужно преобразовать его из формата AVRO в формат JSON. В идеале рекламный техник должен написать код для преобразования отчетов AVRO обратно в JSON.

В нашей лабораторной работе мы воспользуемся предоставленным инструментом aggregatable_report_converter.jar для преобразования отчета AVRO обратно в JSON.

java -jar aggregatable_report_converter.jar \

--request_type convertToJson \

--input_file output.avro

Это возвращает отчет, аналогичный следующему изображению. Вместе с отчетом output.json , созданным в том же каталоге.

Сводный файл avro преобразован в json.

Сводный файл avro преобразован в json.

Откройте файл JSON в любом редакторе по вашему выбору, чтобы просмотреть сводный отчет.

3. Развертывание службы агрегации

Для развертывания службы агрегации выполните следующие действия:

Шаг 3. Развертывание сервиса агрегации : Развертывание сервиса агрегации на AWS

Шаг 3.1. Клонирование репозитория службы агрегации

Шаг 3.2. Загрузка готовых зависимостей

Шаг 3.3. Создание среды разработки

Шаг 3.4. Развертывание службы агрегации

3.1. Клонирование репозитория Aggregation Service

В локальной среде клонируйте репозиторий Aggregation Service Github .

git clone https://github.com/privacysandbox/aggregation-service.git

3.2. Загрузка готовых зависимостей

После того, как вы клонировали репозиторий Aggregation Service, перейдите в папку Terraform репозитория и в соответствующую папку облака. Если ваш cloud_provider — AWS, вы можете перейти к

cd <repository_root>/terraform/aws

В download_prebuilt_dependencies.sh .

bash download_prebuilt_dependencies.sh

3.3.Создание среды разработки

Создайте среду разработки в dev .

mkdir dev

Скопируйте содержимое папки demo в папку dev .

cp -R demo/* dev

Перейдите в папку dev .

cd dev

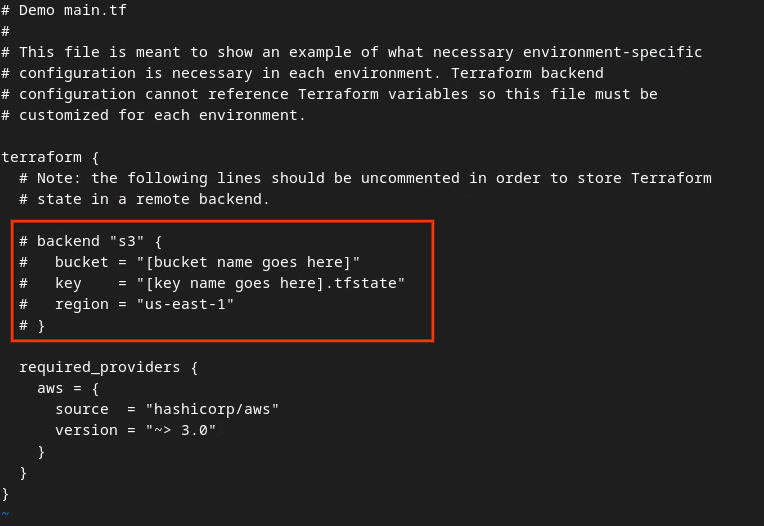

Обновите файл main.tf и нажмите i для input для редактирования файла.

vim main.tf

Раскомментируйте код в красном поле, удалив символ # и обновив имена контейнеров и ключей.

Для AWS main.tf :

Основной файл tf AWS.

Основной файл tf AWS.

Некомментированный код должен выглядеть следующим образом.

backend "s3" {

bucket = "<tf_state_bucket_name>"

key = "<environment_name>.tfstate"

region = "us-east-1"

}

После завершения обновлений сохраните обновления и выйдите из редактора, нажав esc -> :wq! . Это сохранит обновления в main.tf .

Затем переименуйте example.auto.tfvars в dev.auto.tfvars .

mv example.auto.tfvars dev.auto.tfvars

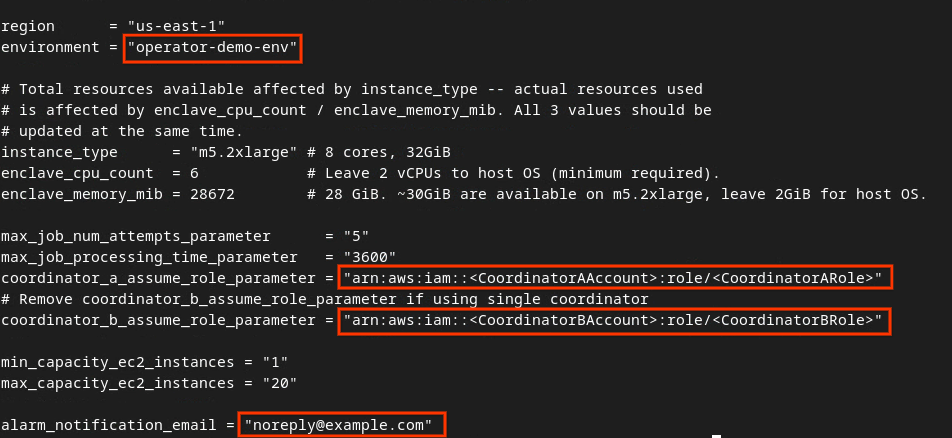

Обновите dev.auto.tfvars и нажмите i для input для редактирования файла.

vim dev.auto.tfvars

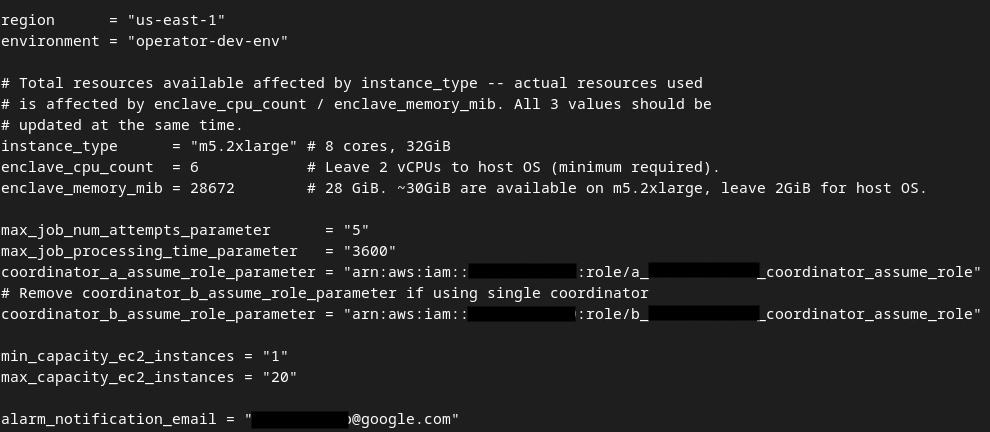

Обновите поля в красном поле на следующем изображении, указав правильные параметры AWS ARN, предоставленные во время подключения к службе агрегации, среды и уведомления по электронной почте.

Отредактируйте файл dev auto tfvars.

Отредактируйте файл dev auto tfvars.

После завершения обновлений нажмите esc -> :wq! . Это сохранит файл dev.auto.tfvars , и он должен выглядеть примерно так, как показано на следующем рисунке.

Обновлен файл dev auto tfvars.

Обновлен файл dev auto tfvars.

3.4. Развертывание службы агрегации

Для развертывания Aggregation Service в той же папке

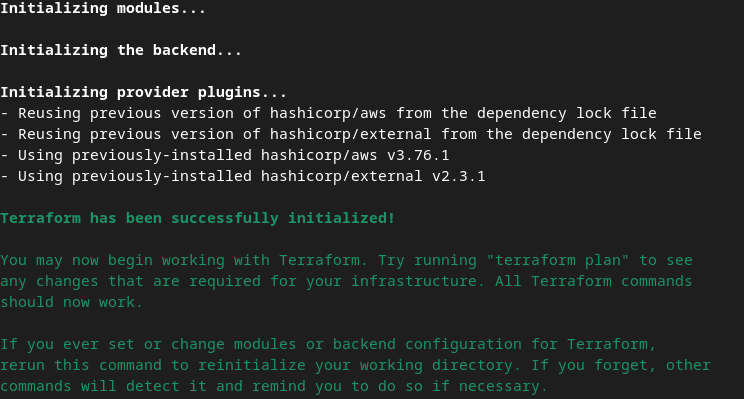

terraform init

В результате должно получиться что-то похожее на следующее изображение:

Инициализация терраформа.

Инициализация терраформа.

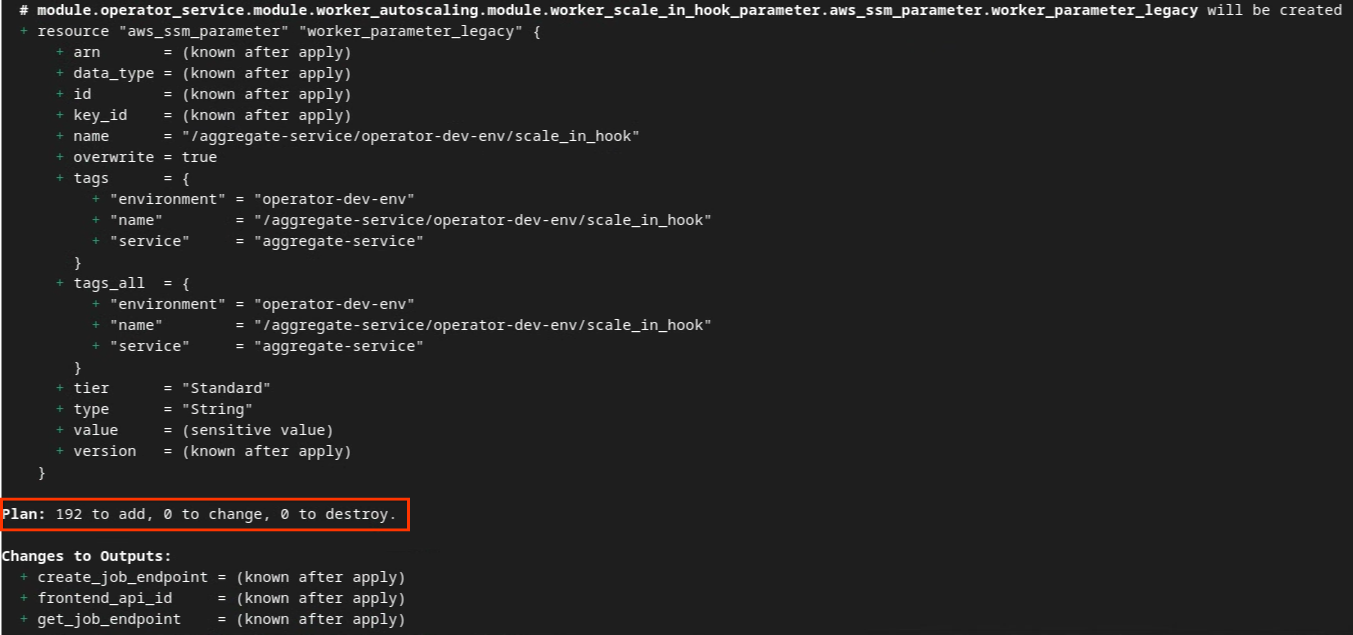

После инициализации Terraform создайте план выполнения Terraform. Где он возвращает количество ресурсов, которые необходимо добавить, и другую дополнительную информацию, похожую на следующую картинку.

terraform plan

Ниже вы можете увидеть сводку " Плана ". Если это новое развертывание, вы должны увидеть количество ресурсов, которые будут добавлены, с 0 для изменения и 0 для уничтожения.

План терраформирования.

План терраформирования.

После этого вы сможете приступить к применению Terraform.

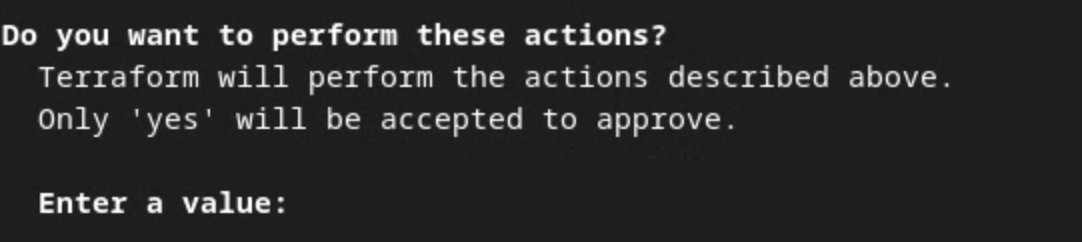

terraform apply

После запроса подтверждения выполнения действий Terraform введите « yes в поле значения.

Запрос на применение Terraform.

Запрос на применение Terraform.

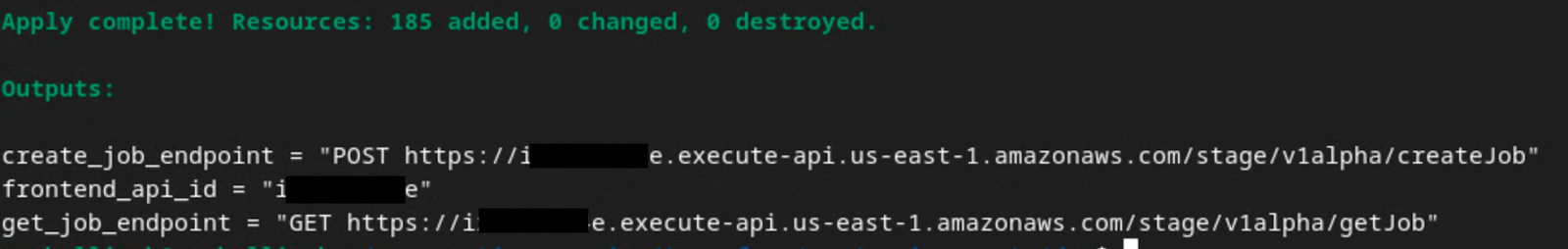

После завершения terraform apply возвращаются следующие конечные точки для createJob и getJob . Также возвращается frontend_api_id , который нужно обновить в Postman в разделе 1.9 .

Применение Terraform завершено.

Применение Terraform завершено.

4. Создание входных данных службы агрегации

Продолжайте создавать отчеты AVRO для пакетной обработки в службе агрегации.

Шаг 4. Создание входных данных службы агрегации : создание отчетов службы агрегации, которые пакетируются для службы агрегации.

Шаг 4.1. Отчет о триггере

Шаг 4.2. Соберите агрегированные отчеты

Шаг 4.3. Конвертация отчетов в AVRO

Шаг 4.4. Создание выходного домена AVRO

4.1 Отчет о триггере

Перейдите на демонстрационный сайт Privacy Sandbox . Это запустит частный отчет агрегации. Вы можете просмотреть отчет по адресу chrome://private-aggregation-internals .

Внутренние компоненты частной агрегации Chrome.

Внутренние компоненты частной агрегации Chrome.

Если ваш отчет находится в статусе « Ожидание », вы можете выбрать отчет и нажать « Отправить выбранные отчеты ».

Отправить частный отчет по агрегации.

Отправить частный отчет по агрегации.

4.2. Собирайте агрегированные отчеты

Собирайте агрегированные отчеты из .well-known конечных точек вашего соответствующего API.

- Частная агрегация

[reporting-origin] /.well-known/private-aggregation/report-shared-storage - Отчет об атрибуции - Сводный отчет

[reporting-origin] /.well-known/attribution-reporting/report-aggregate-attribution

Для этой Codelab вы будете выполнять сбор отчетов вручную. В производстве специалисты по рекламе должны программно собирать и преобразовывать отчеты.

В chrome://private-aggregation-internals скопируйте « Тело отчета », полученное в конечной точке [reporting-origin]/.well-known/private-aggregation/report-shared-storage .

Убедитесь, что в поле « Тело отчета » параметр aggregation_coordinator_origin содержит https://publickeyservice.msmt.aws.privacysandboxservices.com , что означает, что отчет является агрегируемым отчетом AWS.

Частный отчет по агрегации.

Частный отчет по агрегации.

Поместите JSON " Report Body " в файл JSON. В этом примере вы можете использовать vim. Но вы можете использовать любой текстовый редактор, который вам нравится.

vim report.json

Вставьте отчет в report.json и сохраните файл.

Отчет в формате JSON.

Отчет в формате JSON.

4.3. Конвертировать отчеты в AVRO

Отчеты, полученные от конечных точек .well-known находятся в формате JSON и должны быть преобразованы в формат отчета AVRO. После получения отчета JSON перейдите в папку отчета и используйте aggregatable_report_converter.jar для создания отладочного агрегируемого отчета. Это создаст агрегируемый отчет с именем report.avro в вашем текущем каталоге.

java -jar aggregatable_report_converter.jar \

--request_type convertToAvro \

--input_file report.json

4.4. Создайте выходной домен AVRO

Для создания файла output_domain.avro вам понадобятся ключи контейнеров, которые можно извлечь из отчетов.

Ключи контейнера разработаны рекламным техником. Однако в этом случае демо Privacy Sandbox сайта создает ключи контейнера. Поскольку частная агрегация для этого сайта находится в режиме отладки, вы можете использовать debug_cleartext_payload из " Report Body ", чтобы получить ключ контейнера.

Продолжайте и скопируйте debug_cleartext_payload из тела отчета.

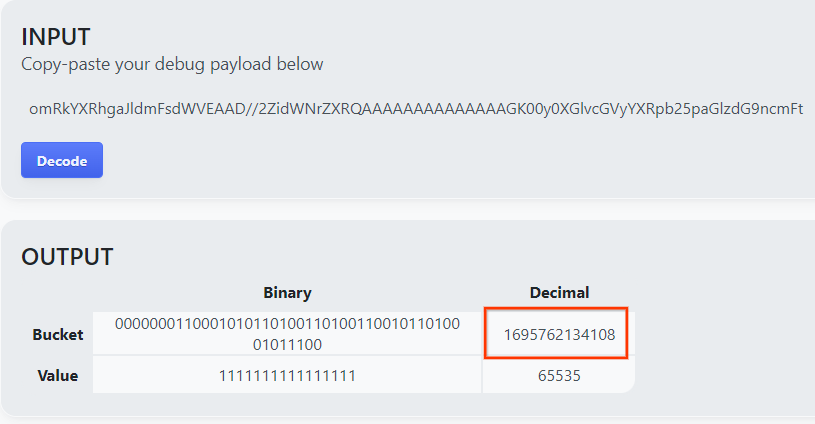

Отладка полезной нагрузки в открытом виде из тела отчета.

Отладка полезной нагрузки в открытом виде из тела отчета.

Откройте goo.gle/ags-payload-decoder , вставьте debug_cleartext_payload в поле « ВВОД » и нажмите « Расшифровать ».

Декодер полезной нагрузки.

Декодер полезной нагрузки.

Страница возвращает десятичное значение ключа контейнера. Ниже приведен пример ключа контейнера.

Результат декодирования полезной нагрузки.

Результат декодирования полезной нагрузки.

Теперь, когда у нас есть ключ контейнера, продолжаем и создаем output_domain.avro . Убедитесь, что вы заменили

java -jar aggregatable_report_converter.jar \

--request_type createDomainAvro \

--bucket_key <bucket key>

Скрипт создает файл output_domain.avro в вашей текущей папке.

4.5. Перемещение отчетов в контейнер AWS

После создания отчетов AVRO (из раздела 3.2.3) и выходного домена (из раздела 3.2.4) приступайте к перемещению отчетов и выходного домена в отчетные сегменты S3.

Если в вашей локальной среде настроен интерфейс командной строки AWS, используйте следующие команды для копирования отчетов в соответствующий контейнер S3 и папку отчетов.

aws s3 cp report.avro s3://<report_bucket_name>/<report_folder>/

aws s3 cp output_domain.avro s3://<report_bucket_name>/<output_domain_folder>/

5. Использование сервиса агрегации

Из terraform apply вы получаете create_job_endpoint , get_job_endpoint и frontend_api_id . Скопируйте frontend_api_id и поместите его в глобальную переменную postman frontend_api_id , которую вы настроили в разделе предварительных условий 1.9.

Шаг 5. Использование службы агрегации : используйте API службы агрегации для создания сводных отчетов и просмотра сводных отчетов.

Шаг 5.1. Использование createJob Endpoint для пакетной обработки

Шаг 5.2. Использование конечной точки getJob для получения статуса партии

Шаг 5.3. Просмотр сводного отчета

5.1. Использование конечной точки createJob для пакетной обработки

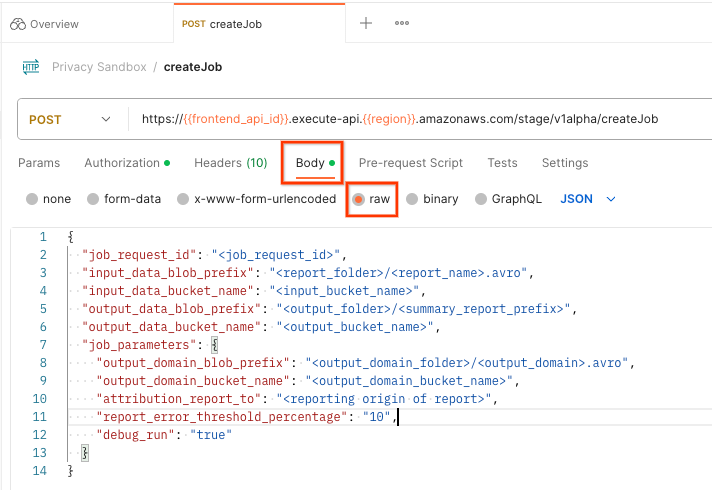

В Postman откройте коллекцию « Privacy Sandbox » и выберите « createJob ».

Выберите « Тело » и выберите « сырой », чтобы разместить полезную нагрузку запроса.

Postman createJob тело запроса

Postman createJob тело запроса

Схема полезной нагрузки createJob доступна на github и выглядит примерно так. Замените <> соответствующими полями.

{

"job_request_id": "<job_request_id>",

"input_data_blob_prefix": "<report_folder>/<report_name>.avro",

"input_data_blob_prefixes": [

"<report_folder>/<report_name-1>/",

"<report_folder>/<report_name-2>/",

"<report_folder>/<report_name>.avro"

], // Mutually exclusive to input_data_blob_prefix as of v2.11.0

"input_data_bucket_name": "<bucket_name>",

"output_data_blob_prefix": "<output_folder>/<summary_report_prefix>",

"output_data_bucket_name": "<bucket_name>",

"job_parameters": {

"output_domain_blob_prefix": "<output_domain_folder>/<output_domain>.avro",

"output_domain_bucket_name": "<bucket_name>",

"attribution_report_to": "<reporting origin of report>",

"reporting_site": "<domain of reporting origin(s) of report>", // Mutually exclusive to attribution_report_to as of v2.7.0

"report_error_threshold_percentage": "10",

"debug_run": "true"

}

}

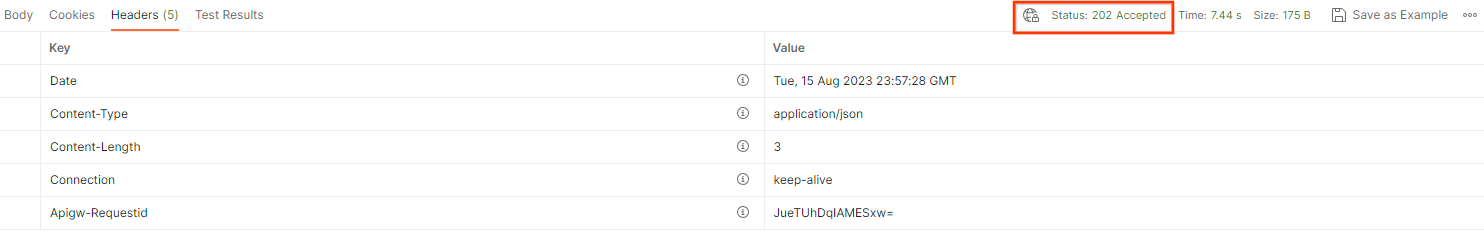

После нажатия « Отправить » создается задание с job_request_id . Вы должны получить ответ HTTP 202, как только запрос будет принят службой агрегации. Другие возможные коды возврата можно найти в кодах ответов HTTP

статус запроса postman createJob

статус запроса postman createJob

5.2 Использование конечной точки getJob для получения статуса партии

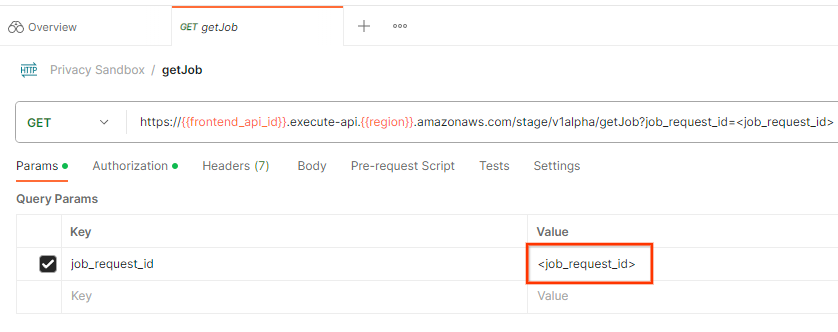

Чтобы проверить статус запроса на работу, вы можете использовать конечную точку getJob . Выберите " getJob " в коллекции " Privacy Sandbox ".

В поле « Params » обновите значение job_request_id до значения job_request_id , которое было отправлено в запросе createJob .

запрос на получение работы почтальоном

запрос на получение работы почтальоном

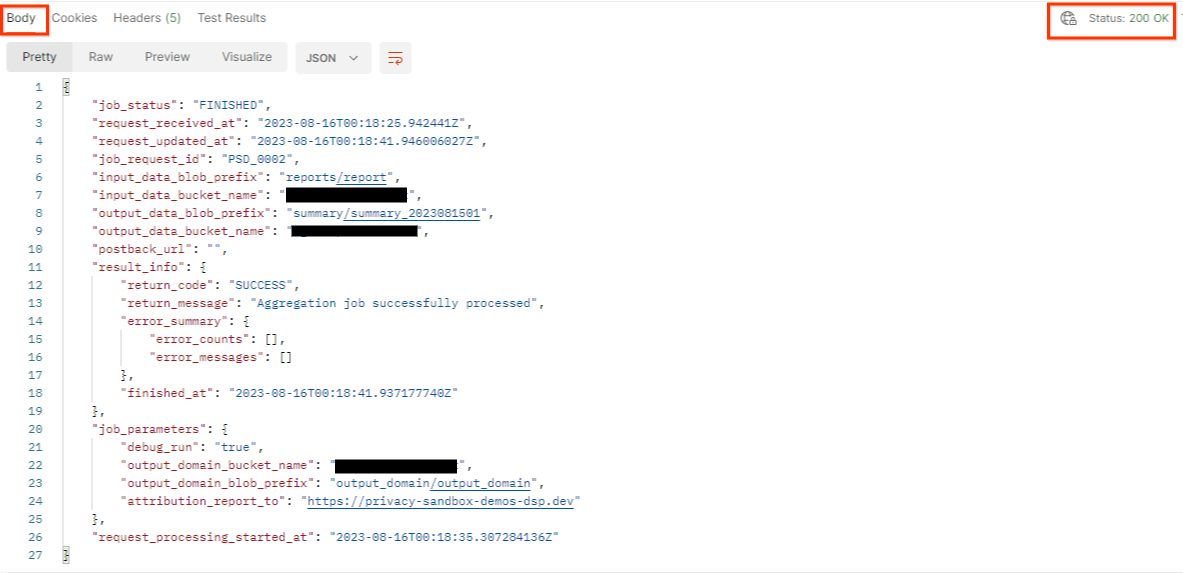

Результат getJob должен вернуть статус вашего запроса на задание со статусом HTTP 200. « Тело » запроса содержит необходимую информацию, такую как job_status , return_message и error_messages (если задание завершилось ошибкой).

статус запроса почтальона getJob

статус запроса почтальона getJob

Поскольку сайт отчетности сгенерированного демо-отчета отличается от вашего сайта, подключенного к вашему AWS ID, вы можете получить ответ с кодом возврата PRIVACY_BUDGET_AUTHORIZATION_ERROR . Это нормально, поскольку сайт источника отчетности отчетов не соответствует сайту отчетности, подключенному к AWS ID.

{

"job_status": "FINISHED",

"request_received_at": "2023-12-07T22:50:58.830956Z",

"request_updated_at": "2023-12-07T22:51:10.526326456Z",

"job_request_id": "<job_request_id>",

"input_data_blob_prefix": "<report_folder>/<report_name>.avro",

"input_data_blob_prefixes": [ // Mutually exclusive to input_data_blob_prefix as of v2.11.0

"<report_folder>/<report_name-1>/",

"<report_folder>/<report_name-2>/",

"<report_folder>/<report_name>.avro"

],

"input_data_bucket_name": "<input_bucket_name>",

"output_data_blob_prefix": "<output_folder>/<summary_report_prefix>",

"output_data_bucket_name": "<output_bucket_name>",

"postback_url": "",

"result_info": {

"return_code": "PRIVACY_BUDGET_AUTHORIZATION_ERROR",

"return_message": "Aggregation job successfully processed",

"error_summary": {

"error_counts": [],

"error_messages": []

},

"finished_at": "2023-12-07T22:51:10.517730898Z"

},

"job_parameters": {

"debug_run": "true",

"output_domain_bucket_name": "<output_domain_bucket_name>",

"output_domain_blob_prefix": "<output_domain_folder>/<output_domain>.avro",

"attribution_report_to": "https://privacy-sandbox-demos-dsp.dev",

"reporting_site": "<domain of reporting origin(s) of report>", // Mutually exclusive to attribution_report_to as of v2.7.0

},

"request_processing_started_at": "2023-12-07T22:51:06.034472697Z"

}

5.3. Рассмотрение сводного отчета

После того, как вы получите ваш сводный отчет в вашем выходном S3 Bucket, вы можете загрузить его в свою локальную среду. Сводные отчеты находятся в формате AVRO и могут быть преобразованы обратно в JSON. Вы можете использовать aggregatable_report_converter.jar для чтения вашего отчета с помощью следующей команды.

java -jar aggregatable_report_converter.jar \

--request_type convertToJson \

--input_file <summary_report_avro>

Это возвращает JSON-файл агрегированных значений каждого ключа сегмента, который выглядит примерно так, как показано на следующем рисунке.

Сводный отчет.

Сводный отчет.

Если ваш запрос createJob включает debug_run как true , то вы можете получить свой сводный отчет в папке отладки, которая находится в output_data_blob_prefix . Отчет находится в формате AVRO и может быть преобразован с помощью предыдущей команды в JSON.

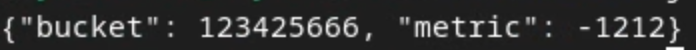

Отчет содержит ключ контейнера, нешумную метрику и шум, который добавляется к нешумной метрике для формирования сводного отчета. Отчет похож на следующее изображение.

Сводный отчет по отладке.

Сводный отчет по отладке.

Аннотации также содержат in_reports и in_domain , что означает:

- in_reports — ключ контейнера доступен внутри агрегируемых отчетов.

- in_domain — ключ контейнера доступен внутри файла AVRO output_domain.